par Henri Masson, Professeur (émérite) à l’Université Antwerpen

Cet article reprend dans une large mesure, une partie de la présentation faite par l’auteur lors de la 12eme conférence annuelle EIKE (Munich 2018). Mais le texte encadrant les diapos PowerPoint de la présentation est inédit, tout comme ce qui constitue le cœur de cette étude : l’analyse des résidus d’ajustement des données Hadcrut 5.0.1.0 par une somme de sinusoïdes ou une droite de régression linéaire.

Préambule

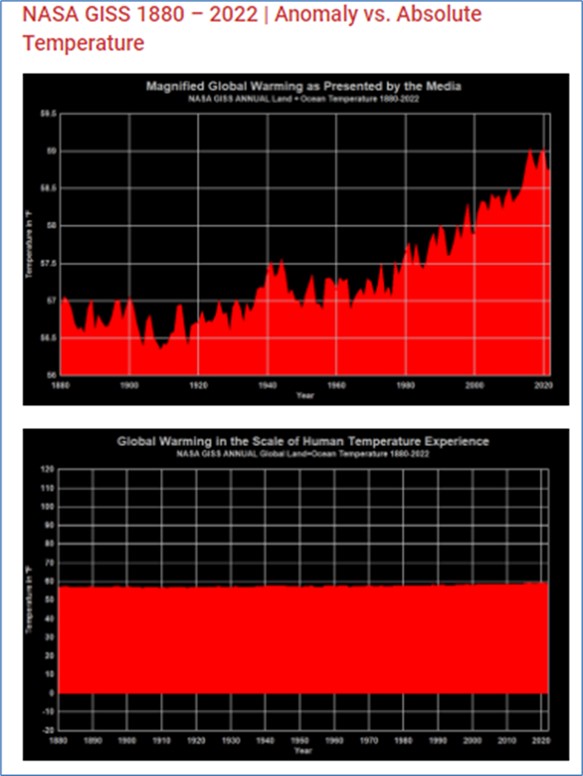

Le réchauffement climatique, requalifié au fil des ans de changement puis de dérèglement, et actuellement d’urgence climatique, est décrit par le GIEC sous forme d’évolution de l’anomalie globale de température par année, décennie ou siècle.

Cette approche, qui a reçu une large couverture médiatique, est fallacieuse à plus d’un titre.

Le souligner est important, car les données expérimentales représentées sous cette forme sont utilisées pour calibrer les modèles mathématiques utilisés par le GIEC et justifier ainsi ses « projections » servant elles-mêmes de base aux recommandations de politique climatique qu’il formule. Ces dernières constituent la « partie émergée de l’iceberg » de ses rapports, sous la forme de « résumés pour décideurs ». Ces résumés, largement remaniés et expurgés politiquement par des représentants des divers gouvernements impliqués, constituent la seule chose que la grande majorité des gens consulte, en particulier, les décideurs politiques à qui il s’adresse et qu’ils sont censés influencer, ainsi que les médias qui y font un large écho, sans que jamais quelqu’un ne s’interroge sur le bien-fondé de la « science » ou sur la qualité des données expérimentales sur lesquelles tout l’édifice repose. La nécessité de combattre le (soi-disant) réchauffement climatique n’est donc rien d’autre qu’une pétition de Principe.

Or, la validité et donc la crédibilité, d’un modèle mathématique dépend à la fois de la qualité de ses données de calibrage, de la qualité des algorithmes utilisés, de l’exactitude des hypothèses sous-jacentes, pas toujours explicites, et de l’ajustement de ses paramètres. Cet ajustement de paramètres doit évidemment correspondre à des valeurs réalistes et pas de convenance opératoire (par exemple pour parvenir à stabiliser et rendre reproductible les résultats des simulations effectuées et qui auraient une fâcheuse tendance à diverger si l’on utilise des valeurs réalistes pour ces paramètres). C’est malheureusement le cas pour les modèles dits « à circulation globale » sur lesquels le GIEC base ses travaux.

Le présent article examine spécifiquement la confiance que l’on peut avoir, ou pas, dans les anomalies de température globale. Il passe en revue un certain nombre de problèmes liés à leur construction et utilisation, exclusivement du point de vue de l’analyse de données, sans se prononcer sur d’autres aspects de la « science » sous-jacente aux rapports du GIEC ou des simulations numériques qu’il utilise. Il s’agit là d’un autre exercice d’audit de qualité, qui mériterait certainement d’être effectué par des experts indépendants, en respectant les règles de bonne pratique en la matière.

Les méthodes utilisées dans la présente étude sont génériques et s’appliquent aussi bien aux données socio-économiques, épidémiologiques, biologiques, etc. qu’aux données climatiques. Elles sont conformes à « l’état de l’art » en matière d’analyse de données. Cette précision réfute à l’avance toute critique éventuelle « d’incompétence climatique » formulée à l’égard de l’auteur

Tout indicateur doit avoir un sens physique

Avant toute chose, il convient de remarquer que la température est thermodynamiquement une grandeur intensive, donc locale par essence.

Ensuite utiliser une échelle de température exprimée en degrés Celsius ou Fahrenheit est une simple convention pratique, seule la température absolue, exprimée en degrés Kelvin (degré centigrade + 273.15) a un sens thermodynamique. Pire encore, considérer des variations d’anomalies de température par rapport à une température arbitrairement choisie, relève de la manipulation des plus grossières, visant à alarmer indûment la population, à moins qu’il ne s’agisse plus simplement d’inculture scientifique (Figure 1).

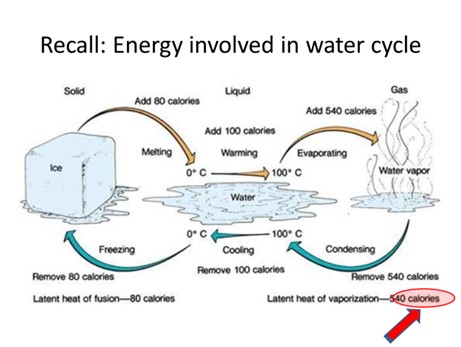

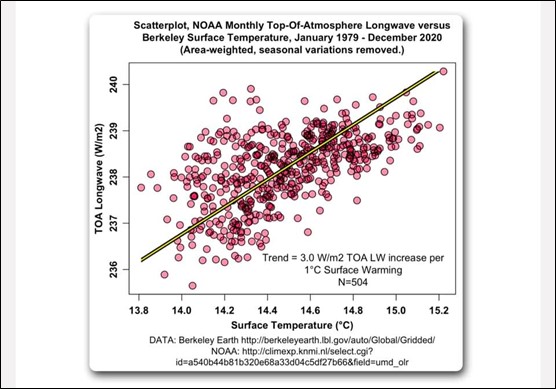

En réalité, la Nature joue un excellent rôle de thermostat naturel, notamment via les chaleurs d’évaporation – condensation le long du cycle de l’eau (Figure 2).

Mais ce n’est pas tout ; calculer des moyennes spatiales et temporelles de température pose problème.

Un indicateur doit être spécifique (critique des moyennes spatiales)

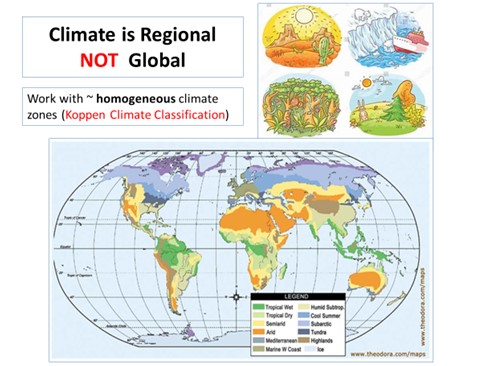

Avant toute chose, il est bon de se rappeler qu’un climat global n’existe pas, tous les géographes vous le diront (Figure 3).

Les composantes cycliques apériodiques et non synchrones

De plus, moyenner spatialement des anomalies locales de température efface en grande partie les composantes saisonnières. Lorsque l’hémisphère Nord est en hiver, l’hémisphère Sud est en été. A première vue, ces cycles naturels devraient se compenser et donc s’annuler en les sommant.

Mais en plus, des phénomènes géophysiques, comme le vortex polaire descendant pour un temps le long de l’une ou l’autre longitude, ou El Nino, interviennent également et provoquent des fluctuations de température cycliques locales mais asynchrones d’un point à l’autre du Globe.

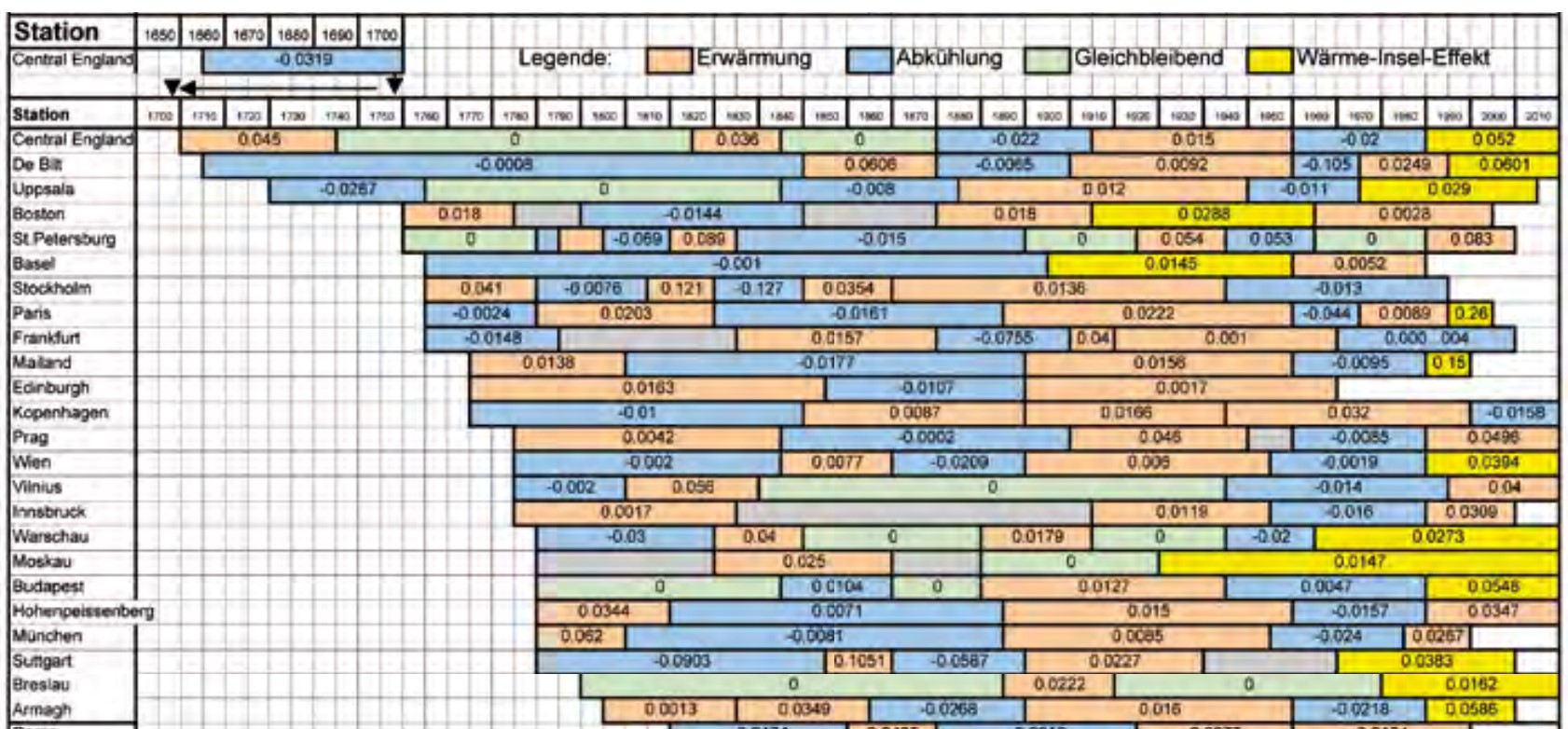

Moyenner spatialement élimine dans une certaine mesure ces fluctuations naturelles, et minimise leur effet sur un indicateur global ; mais, considérées localement, elles jouent un rôle plus important que les anomalies globales de température. C’est une des raisons pour lesquelles les modèles du GIEC, calibrés sur les anomalies globales de température sont incapables de décrire correctement les fluctuations locales ou régionales de température : Ces modèles sous-estiment algorithmiquement les fluctuations naturelles locales. Or ce sont celles-ci qui importent. En effet, les conséquences du changement climatique, comme les sécheresses, inondations, tornades voire la nécessité de transformer une population entière en réfugiés climatiques, s’évaluent localement. Il y a donc des raisons objectives de travailler avec des grandeurs locales plutôt qu’avec des indicateurs globaux n’ayant aucun sens physique, et introduisant de plus des biais et fausses tendances, comme il sera montré ci-dessous (Figure 4).

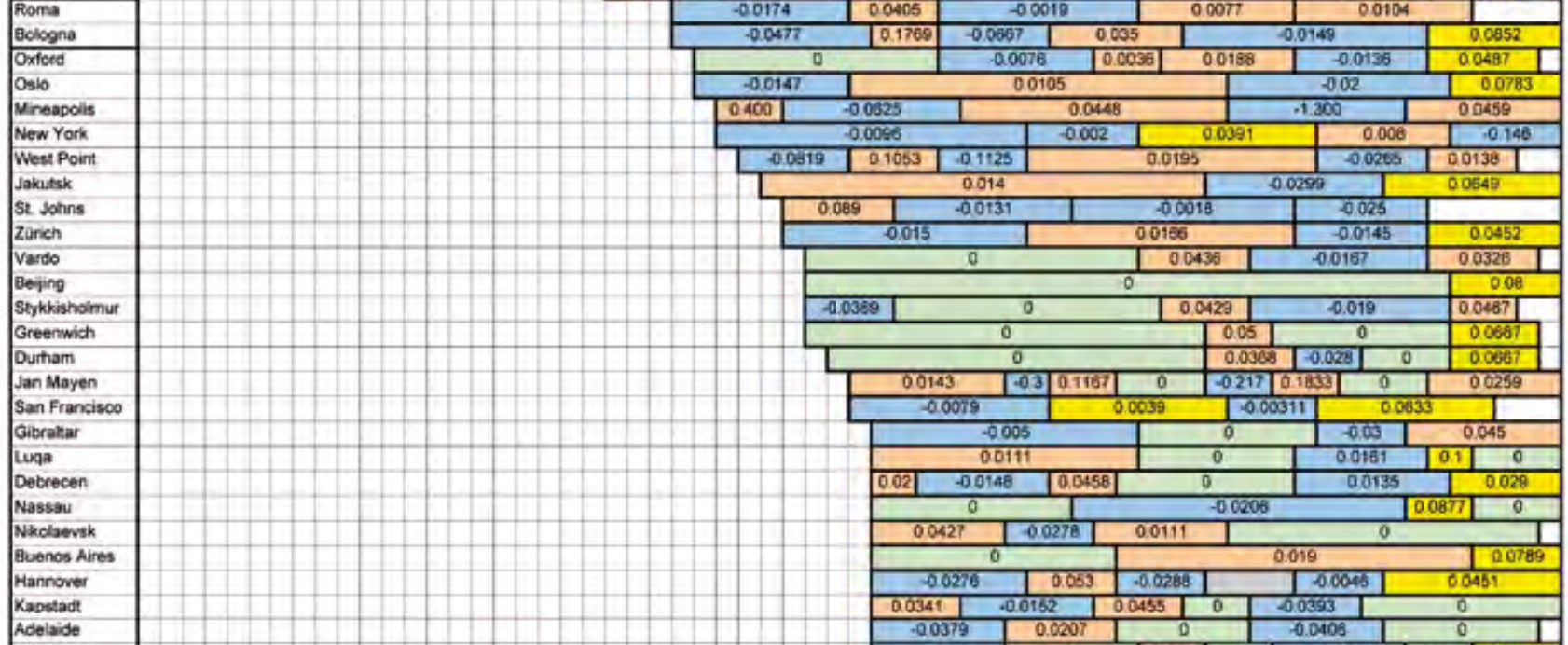

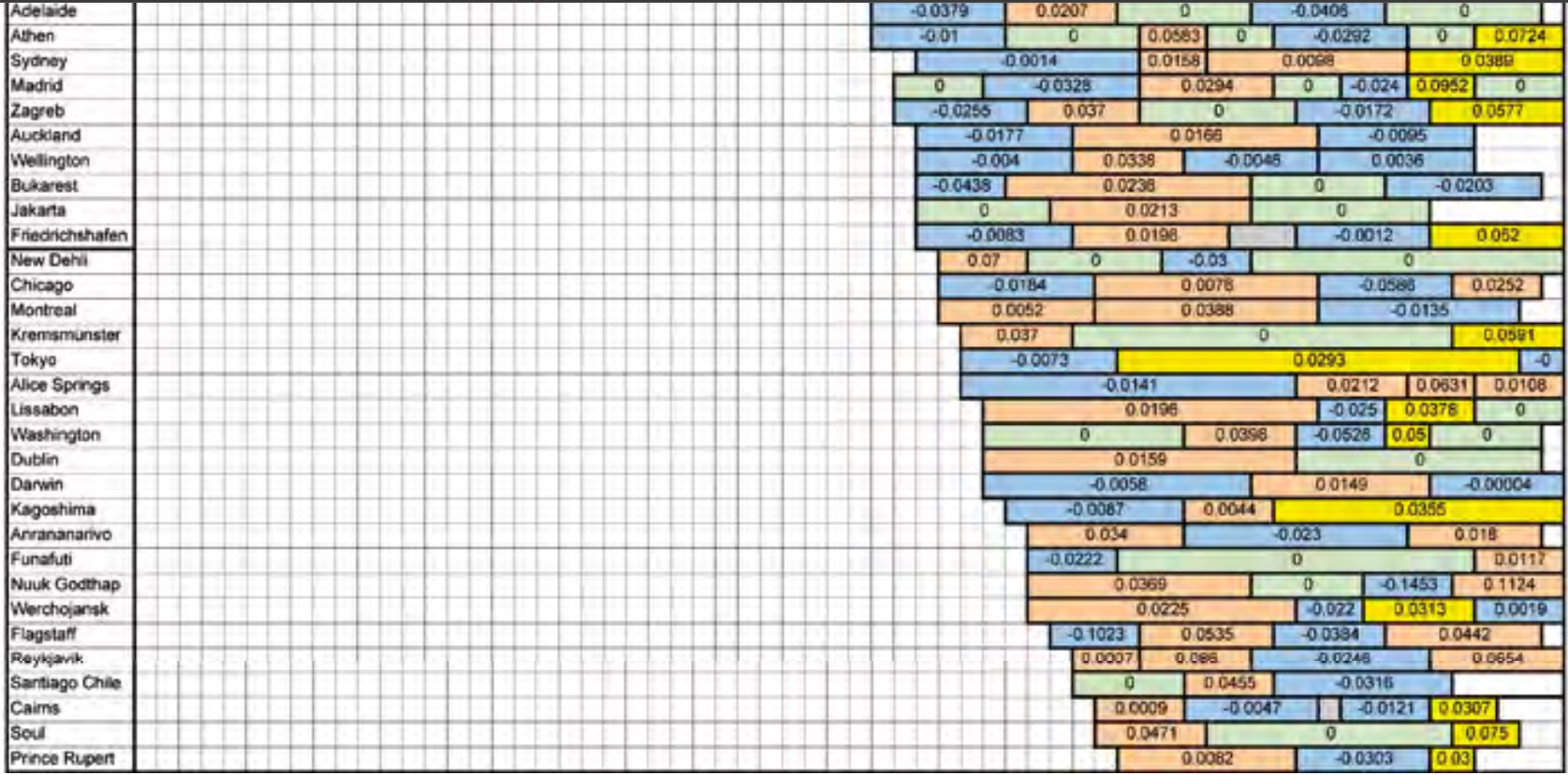

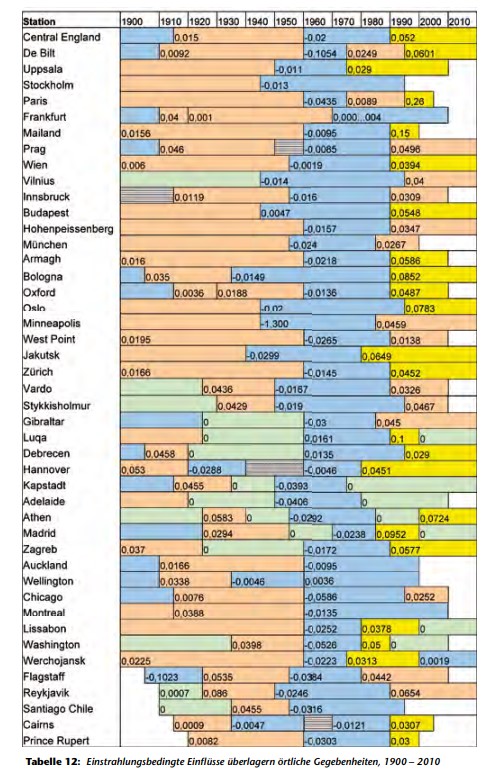

Figure 4 : Historique des fluctuations de température locale. Localement la température varie de façon cyclique mais également de façon asynchrone d’un point à l’autre. Moyenner des signaux cycliques non synchrones pour en faire un indicateur global efface ces fluctuations. Mais les conséquences climatiques se ressentent localement. Par conséquent, utiliser un indicateur global pour évaluer un effet local sous-estime l’effet des variations climatiques en un point donné. (Traduction des codes couleurs donnés en haut de l’image, de gauche à droite : réchauffement, refroidissement, stabilisation, effet d’îlot urbain). Les chiffres dans les cases correspondent aux augmentations ou dimunitions de température sur la période considérée » (Source: Ewert F.K. Fusion 32, 2011 Nr3 pg 31-61).

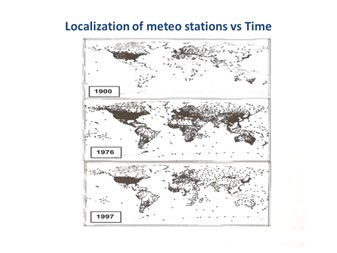

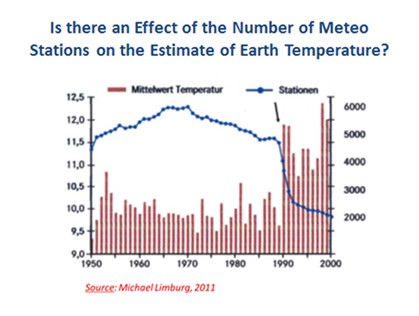

Un autre problème affectant la qualité des mesures globales réside dans le fait, qu’au fil du temps, le nombre de stations a considérablement diminué, notamment suite à la décolonisation du continent africain et à l’effondrement de l’URSS, et des restrictions budgétaires qui en ont découlé, à la fin du siècle précédent (Figures 5a et 5b)

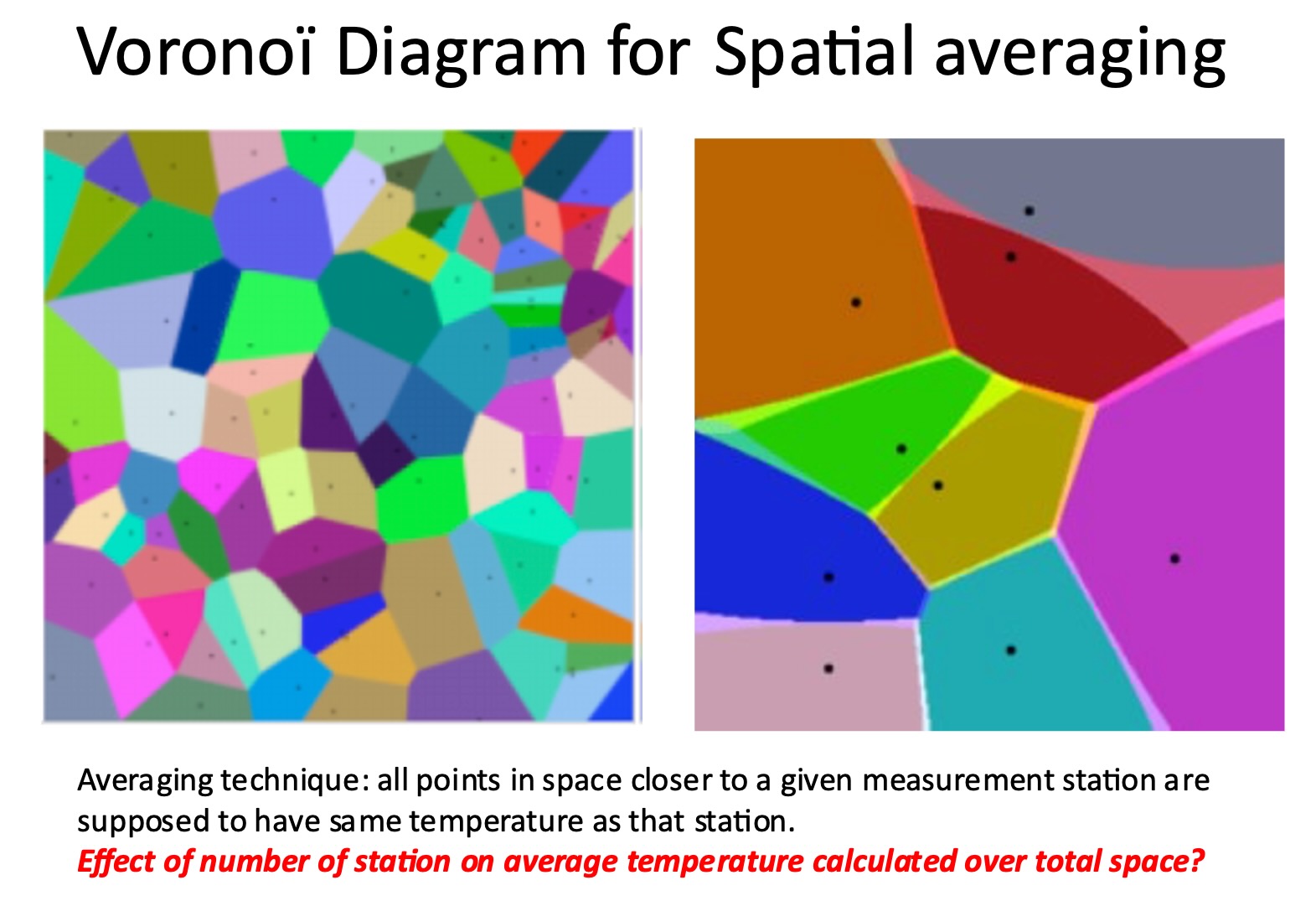

Or pour calculer la température globale moyenne ou son anomalie, on utilise une forme de pondération des mesures ponctuelles, par des algorithmes comme celui de VoronoÏ. Ce dernier attribue la température d’une station de mesure à tous les points qui sont plus proches de cette station de mesure que d’une autre, définissant ainsi une « zone de contrôle » (Figure 6).

Lorsque le nombre de stations diminue, la représentativité de l’ensemble des stations toujours active diminue, mais aussi la surface de contrôle correspondant aux sites voisins mais toujours actifs augmente, ce qui change leur pondération dans le calcul des moyennes globales. Des discontinuités en résultent dans les mesures globales

Moyennes temporelles

Le GIEC exprime ses résultats sous forme de moyennes mensuelles ou annuelles.

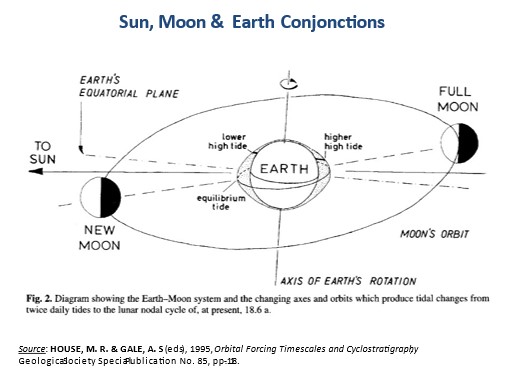

Il se fait que non seulement le Soleil, mais également la Lune, plus petite mais beaucoup plus proche de la Terre, modifient l’ensoleillement local, les forces gravitationnelles (le célèbre problème des 3 corps en mécanique) modifiant légèrement l’orientation de l’axe de rotation de la Terre et donc de son inclinaison par rapport au plan de l’écliptique (Figure 7). Or, dans une année solaire il y a mathématiquement 13 mois lunaires (365/28 ~ 13.04) alors que le calendrier sur lequel nous calculons des moyennes mensuelles contient 12 mois de longueur inégale. Il en résulte qu’une date du calendrier solaire, correspond, d’année en année, à des phases différentes de la Lune. Ce fait, bien connu des jardiniers qui « plantent avec la Lune », est totalement négligé par les climatologues. Malheureusement pour ces derniers, Il en résulte aussi, d’année solaire en année solaire, un résidu d’ajustement temporel d’amplitude comparable aux anomalies de température, qui sont prises comme indicateur de changement climatique. Ce qui brouille considérablement les cartes.

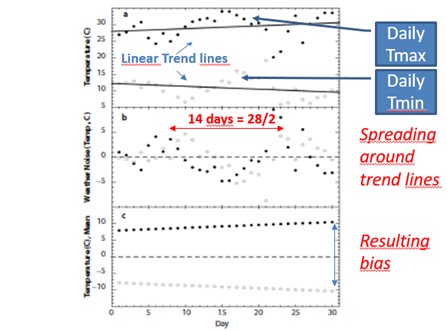

Ce fait est négligé car ce n’est que très rarement que l’on prend en compte les variations de température d’un jour à l’autre, la plus grande résolution temporelle utilisée étant mensuelle. Mais si l’on examine les variations quotidiennes de température en un point donné, une périodicité de ~14 jours (à peu près l’harmonique d’ordre de 2 de 29.3 jours caractérisant le mois lunaire) est nettement apparente, comme illustré sur la figure 8 ci-dessous.

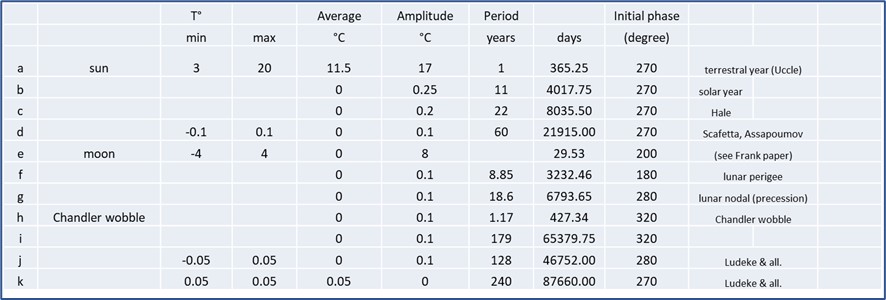

Les erreurs induites par cette non-concordance des calendriers peut être illustrée simplement en superposant à une dizaine de sinusoïdes de 365,25 jours, une sinusoïde de moindre amplitude dont la période est de 29,53 jours. Quelques sinusoïdes de très faible amplitude ont été ajoutées pour bruiter le signal. Leurs périodes correspondent à des cycles astrophysiques connus perturbant les orbites de la Terre autour du soleil et de la Lune autour de la Terre. Les paramètres utilisés sont regroupés au Tableau 1 ci-dessous.

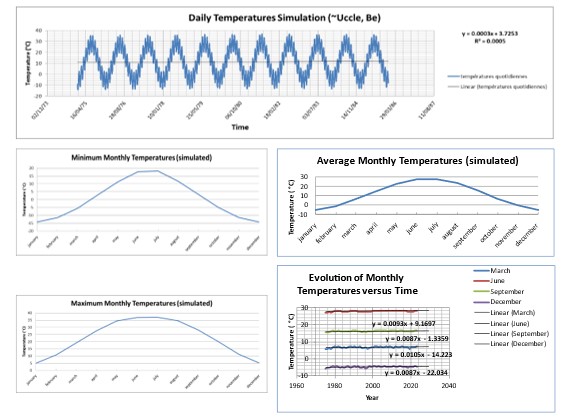

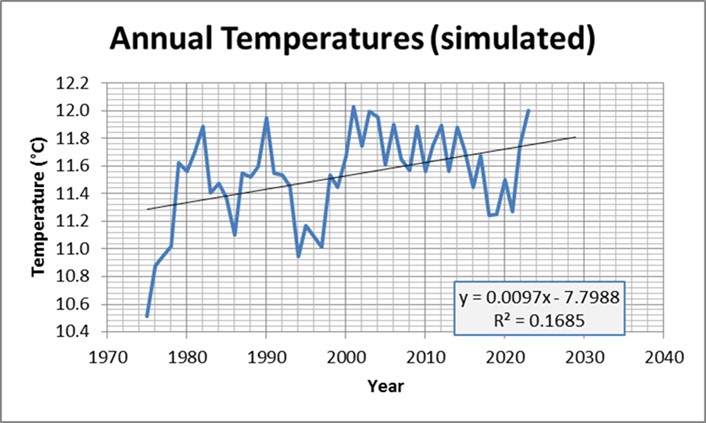

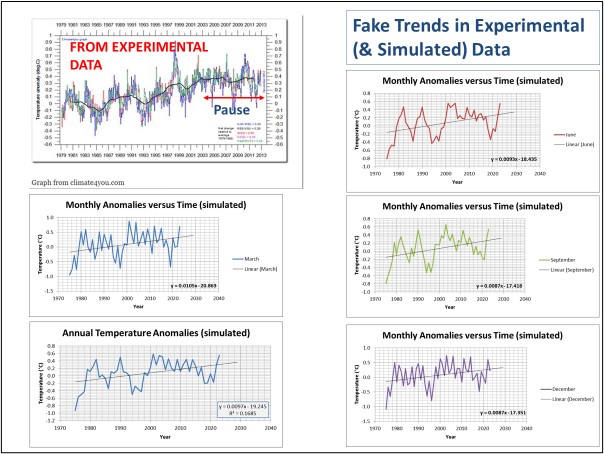

Quelques résultats illustratifs de la simulation sont reproduits aux Figures 9, 10 et 11 ci-dessous.

L’évolution des températures mensuelles simulées est représentée à la Figure 10. Pour la valeur choisie des paramètres, Un profil comparable aux anomalies de température est généré, y compris une pente positive de la droite de régression. Le GIEC attribue les soubresauts de la courbe à des phénomènes naturels de courte durée (El Nino, volcanisme, etc.). Il est à remarquer que la simulation présente également une « pause. », comme les anomalies de température calculées à partir des données météorologiques.

La Figure 11 permet la comparaison directe de ces simulations avec les anomalies de température. La ressemblance est frappante. Nous laissons au lecteur le soin d’en tirer ses conclusions personnelles.

Au passage, remarquons que l’amplitude des marées océaniques résulte essentiellement de l’effet de la Lune, modulé par l’effet de la position du Soleil, ce qui occasionne les grandes marées et affecte la distribution des courants marins. Il n’est pas interdit de penser, bien que les données précises fassent défaut, que les mêmes forces gravitationnelles influent sur la structure et la dynamique de l’atmosphère, présentant une inertie 1000 fois moindre que l’océan, par exemple sur la position des jet streams ou les caractéristiques de la circulation de Walker, des cellules de Hadley ou encore des cellules polaires.

Remarquons aussi que ce déphasage variable d’année en année entre calendrier solaire et lunaire est aussi la raison pour laquelle le Ramadan, basé sur un calendrier lunaire, se produit à des dates différentes, d’année en année, en se référant au calendrier solaire.

Les anomalies locales de température

Mais même si l’on se cantonne à utiliser des indicateurs locaux, des problèmes subsistent. Le concept d’anomalie locale de température, prôné par la WMO (World Meteological Association) consiste à comparer la température observée en un point à la moyenne calculée sur une période de référence donnée de 30 ans. La justification des anomalies de température réside dans le fait qu’il s’agit d’une méthode commode pour comparer les variations de température en divers point du globe, les températures locales pouvant varier de l’ordre de 100°C entre les Pôles et l’Equateur. Il a été convenu initialement, de réajuster la période de référence tous les 30 ans (1930-1960, 1960-1990, 1990-2020). Le dernier ajustement est toujours l’objet d’âpres discussions, la WMO préférant garder la période de référence 1960-1990. Certains, qualifiés de complotistes par la « Science climatique officielle » y voient une volonté désespérée de camoufler le fait que ces anomalies, comparées à la période 1990-2020 ont une fâcheuse tendance à stagner, ce qui compromet gravement l’agenda politique lié à la (soi-disant) urgence climatique.

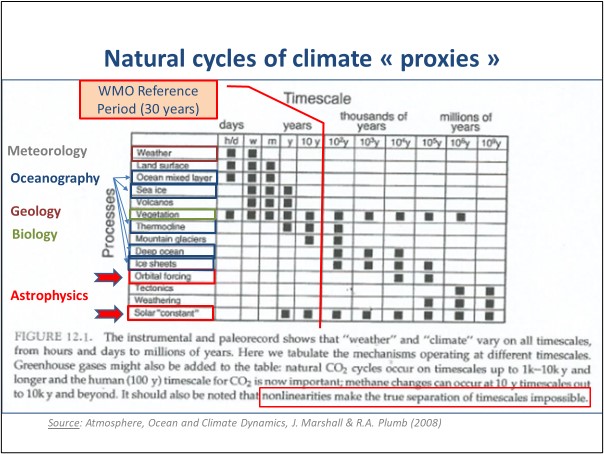

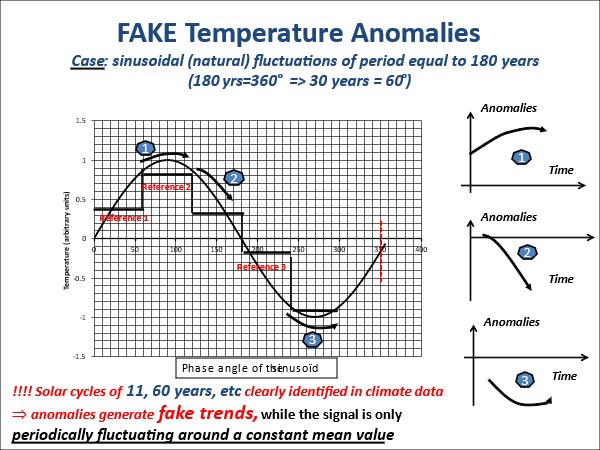

Malheureusement, les anomalies de température introduisent des fausses tendances et des biais induits par des composantes cycliques naturelles de température dont la période excède la période de référence utilisée pour calculer les anomalies (30 ans), et de telles composantes climatiques naturelles sont nombreuses (cfr Tableau 2).

Illustrons le mécanisme avec une simple sinusoïde de période égale à 180 ans (une composante périodique bien connue des séries temporelles climatiques), et voyons ce que donnerait le calcul des anomalies le long de cette sinusoïde, la période de référence étant 30 ans, comme il est d’usage (Figure 12).

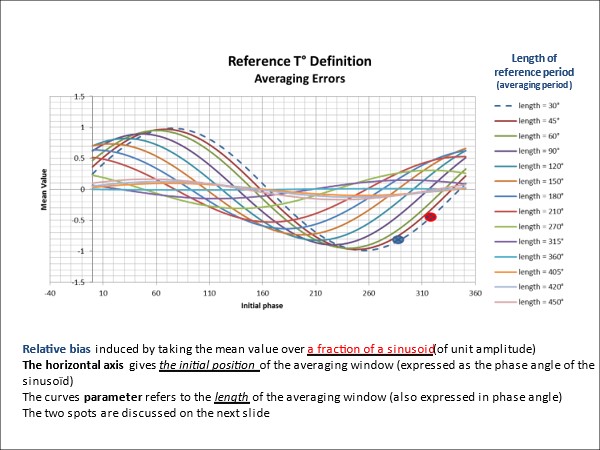

Outre de fausses tendances, le concept d’anomalie induit également des biais variables selon l’instant initial et la longueur de la période de référence, dans le cas d’un signal polycyclique. L’effet a été simulé à la Figure 13, pour le cas d’une simple sinusoïde. Cet effet produit non seulement des biais mais également des discontinuités lorsqu’on passe d’une période référence à une autre.

Pour résumer nos griefs, disons simplement que l’utilisation d’anomalies de température pose un triple problème « mathématique : elle induit des fausses tendances, des biais et occasionne des problèmes de raccord lorsqu’on passe d’une fenêtre de référence à l’autre (1930-1960, 1960-1990, et éventuellement 1990-2020, pour reprendre la convention de la WMO et du GIEC, qui n’est pas celle de la Nasa ; cette dernière initie sa première période de référence au moment du lancement des premiers satellites météo ; ce qui, bien que logique dans son chef, ajoute encore à la confusion).

Fiabilité des mesures locales

Après avoir montré les dangers résultant de l’utilisation d’anomalies de température, qu’elles soient globales ou locales, il convient aussi de s’interroger sur la qualité des mesures individuelles « brutes » telles que collectées et enregistrées dans les bases de données « primaires » dont sont extraites les moyennes mensuelles, annuelles et leurs anomalies

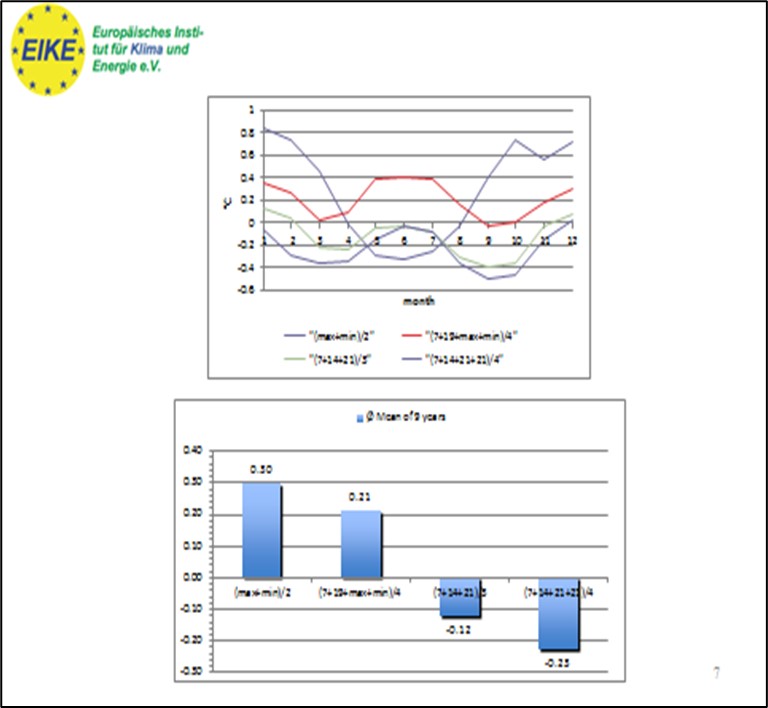

La température du jour

La température varie au long d’une journée, avec une amplitude qui dépend de la couverture nuageuse locale, jouant le rôle de persienne pendant le jour et de couverture pendant la nuit. Plus la couverture nuageuse est importante, moins grande est l’amplitude des variations de température jour-nuit. En l’absence de nuages, les variations quotidiennes de température peuvent dépasser 20°C en moyenne montagne européenne, par exemple. Se pose donc la question de savoir quelle température est représentative d’une journée donnée. En fait, il y a plusieurs méthodes différentes (moyenne maximum + minimum, moyenne de températures relevées à des heures précises, relevé continu et moyenne des mesures, etc.) et ces méthodes ne sont pas toujours explicitées. Ce qui constitue un premier type d’erreur (Figure 14).

Relevés terrestres

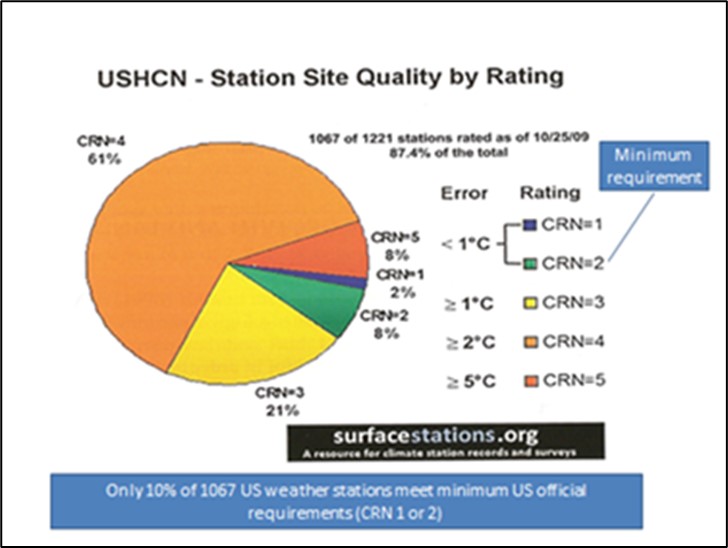

Les séries de mesures les plus longues, enregistrées par thermomètre ont environ 300 ans. Les conditions ont été progressivement normalisées pour aboutir aux abris Stevenson ; ceux-ci ont été remplacés ultérieurement et progressivement par des capteurs (thermocouples thermistances ou thermomètre à filament de platine), nécessitant à chaque fois des recalibrages. L’environnement de ces capteurs a par ailleurs été modifié au fil du temps par urbanisation, asphaltage, etc. (« effet d’îlot urbain ») Un grand nombre de ces capteurs sont maintenant localisés à proximité immédiate de bâtiments accumulant ou réfléchissant les radiations solaires, parfois à proximité d’installations de conditionnement d’air, si ce n’est sur le tarmac d’aéroport à portée des gaz d’échappement des avions et autres engins manœuvrant sur les pistes. Il a été estimé, sur base d’une vaste enquête menée par Antony Watts (du site WattsUpWithThat), que seules 10 % des installations sur le sol américain présentent une erreur de mesure inférieure à 1°C (Figure 15).

Les données manquent pour les autres pays, mais on peut raisonnablement penser que le résultat sera comparable, si pas pire. De plus, une correction d’altitude du point de mesure doit être effectuée pour ramener toutes les températures au niveau de la mer. Cette correction est purement théorique basée sur une détente adiabatique au sein de l’atmosphère, une tendance qui ne se vérifie pratiquement jamais, comme les relevés par ballon sonde le prouvent.

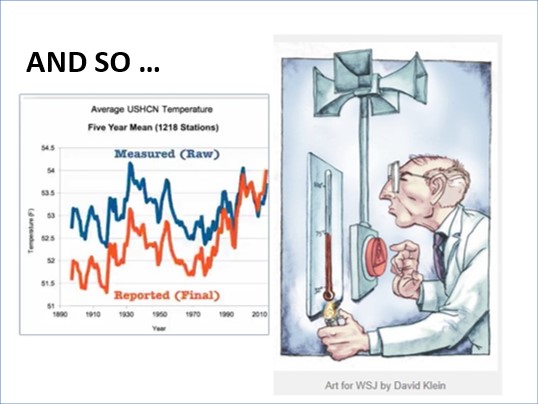

Nous sommes donc en présence de plusieurs erreurs, indépendantes les unes des autres, assez souvent corrigées manuellement de façon arbitraire et non transparente, et qui s’accumulent.

Les stations météos sont très utiles pour décrire les conditions locales et faire des prévisions à court terme, mais pas du tout adaptées, de par les erreurs qui entachent les mesures que l’on peut y effectuer, à détecter des fluctuations locales de température de l’ordre du centième de degré par an, comme prétend le faire le GIEC.

Relevés au niveau des océans

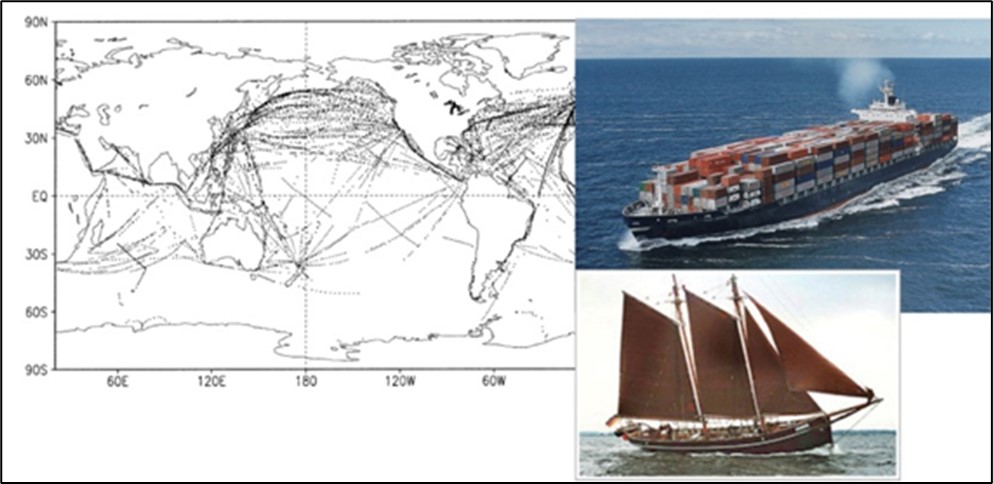

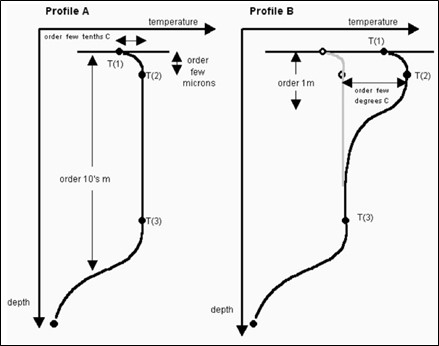

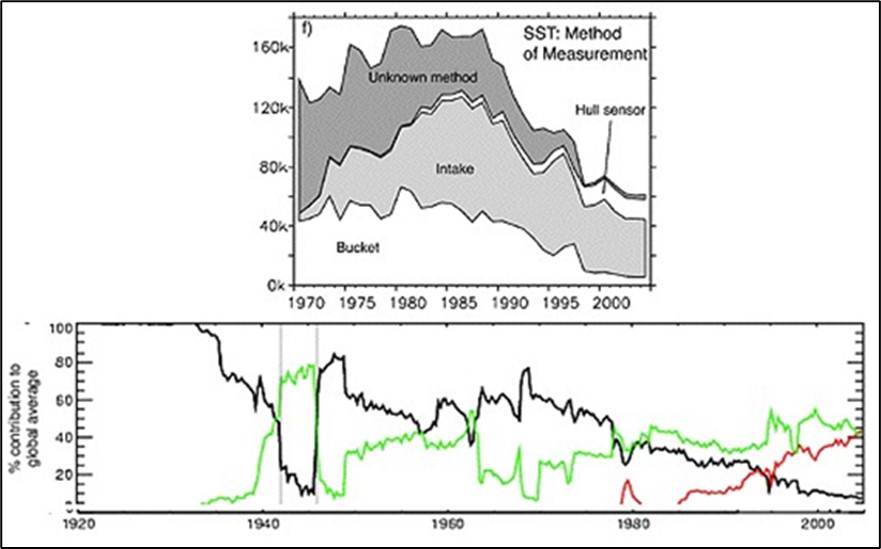

Historiquement les mesures de température en mer se faisaient par empotement, dans des conditions plus ou moins normalisées ; elles furent progressivement remplacées par des mesures de température d’eau à l’entrée des circuits de refroidissement des machines, et plus récemment par un réseau de bouées imergeables mesurant la température de surface et à différentes profondeurs au sein des océans. L’essentiel des mesures avant la mise en service des bouées se faisait donc le long des routes commerciales les plus fréquentées, ce qui pose un problème de représentativité, et avec deux techniques différentes, ce qui pose un problème de calibrage et de raccord lorsqu’on passe d’une technique de mesure à l’autre (Figures 16 et 17).

Ces mesures sont des mesures de température d’eau de surface (SST, Sea Surface Temperature) qui ne sont pas exactement égales aux températures de l’air, tant que le système océan-atmosphère n’est pas à l’équilibre ; ce qu’il n’est jamais.

Les bouées, quant à elles, dérivent librement le long des courants de surface et finissent par remplir peu à peu les océans de façon relativement uniforme, donnant ainsi une meilleure représentativité spatiale des mesures, mais la longueur des séries temporelles de mesures collectées ne dépasse pas quelques dizaines d’années dans les meilleurs des cas, ce qui est trop court pour être de la moindre utilité dans le débat climatique.

La réconciliation des mesures de SST obtenues par différentes méthodes est ardue, du fait que la proportion des techniques utilisées a fortement varié au fil du temps, et surtout parce que pour une bonne partie d’entre elles, la méthode de mesure n’a même pas été identifiée (Figure 18).

Mesures par satellites

Les mesures par satellite présentent l’avantage d’une couverture spatiale uniforme et représentative. Elles souffrent de problème de déviations d’orbite au fil du temps, voire du remplacement d’un satellite par un autre, ce qui pose des problèmes de calibrage et de raccord. Les estimations de température de surface, sur terre et sur les océans, sont basées sur des algorithmes complexes qui sont eux aussi entachés d’erreurs de calibrage. Au contraire des mesures de surface qui mesurent directement la température de l’air ou de la surface de l’océan, les mesures par satellites sont basées sur l’ interprétation des radiations émises par le sol ou la surface des océans, et en déduisent les températures correspondantes ; en utilisant des techniques de calibrage complexes, entachées elles aussi d’erreurs considérables (Figure 19).

Les satellites, les bouées et les thermomètres ne mesurent donc pas la même chose. Les différences sont faibles, mais comparables aux tendances de changement climatique que le GIEC prétend détecter sur une décennie.

Suivons malgré tout le GIEC

Admettons ces imperfections, pour ne pas dire erreurs fondamentales, expérimentales, mathématiques ou algorithmiques, et concentrons-nous donc, comme le fait le GIEC, sur les anomalies globales de température et sur la façon de les interpréter.

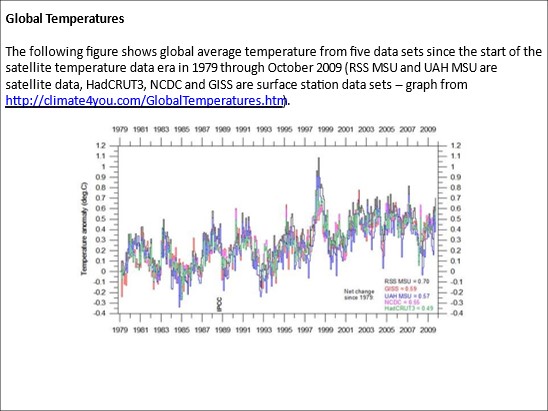

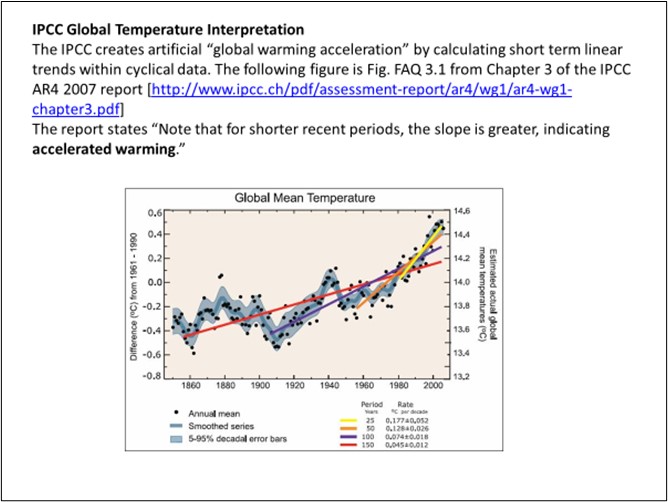

Le GIEC base essentiellement ses travaux sur les anomalies de température de la période 1980-2022, prétendant que c’est la seule fenêtre temporelle où l’on dispose de mesures fiables, représentatives et distribuées spatialement de façon satisfaisante. Le GIEC présente aussi ses conclusions sous forme de droite de régression ajustant au mieux linéairement les anomalies de température calculées, et déduit de la pente de cette droite de régression une augmentation de température, annuelle, décennale ou centennale, qui fait les gros titres des journaux et pousse les décideurs politiques à adopter, dans l’urgence, des politiques zéro carbone, aux coûts faramineux, pour (soi-disant) sauver la Planète.

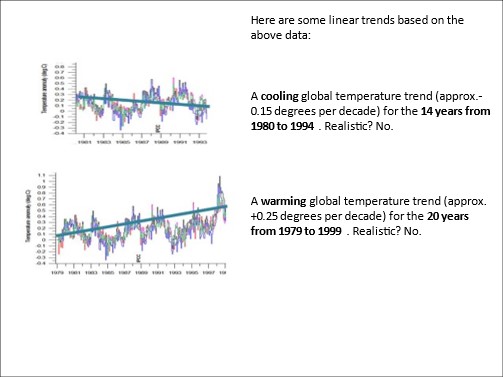

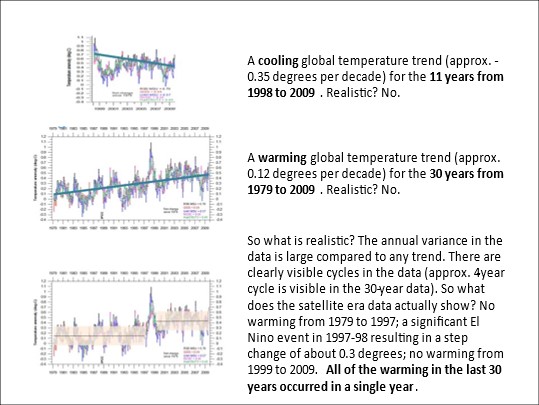

Remarquons au passage, comme illustré par l’exemple ci-dessous, que changer le début et la longueur de cette fenêtre de mesure conduit à des résultats radicalement différents,

Un esprit mal tourné pourrait penser que la date de 1980, initiant la fenêtre de mesure utilisée par le GIEC, n’aurait donc pas été choisie par hasard. Elle correspond en effet à un minimum de température dans les relevés de température de plus longue durée.

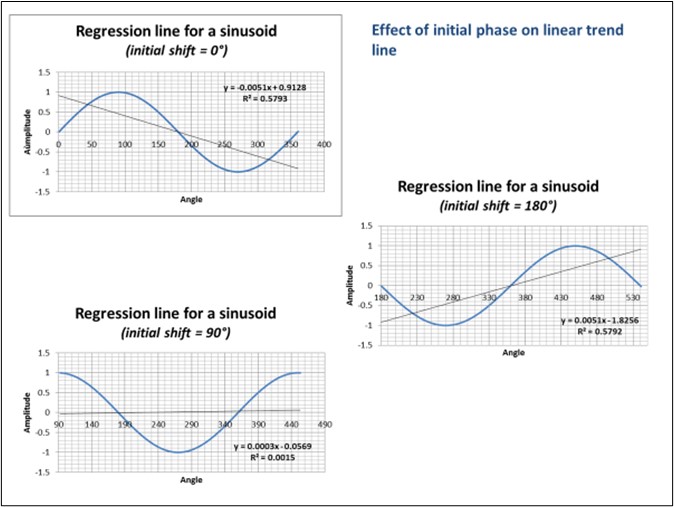

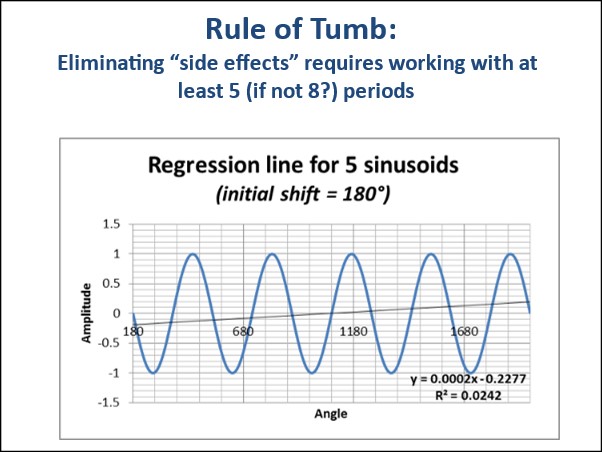

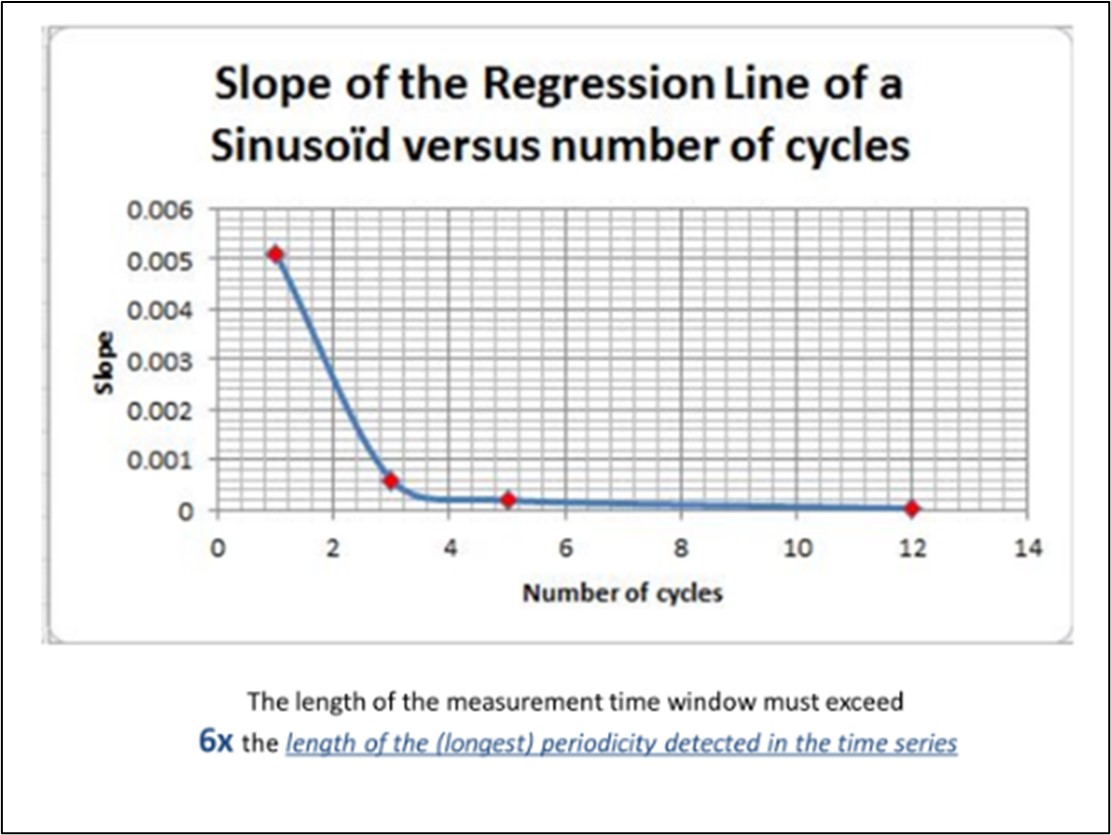

Soit, mais revenons à quelques considérations plus basiques. Il faut savoir que comparer la durée de la fenêtre de mesure aux périodes de composantes cycliques est une des opérations préliminaires de toute analyse sérieuse de séries temporelles. Pour illustrer son importance, on peut considérer une simple sinusoïde de période comparable à la fenêtre de mesure, et tracer les droites de régression correspondant à divers déphasages de la sinusoïde par rapport à la fenêtre de mesure, pour s’apercevoir que l’on obtient tout et n’importe quoi comme résultat, alors que la pente devrait être nulle, une sinusoïde oscillant autour d’une horizontale. Une règle de bonne pratique veut que la fenêtre de mesure excède 6 fois la période de la sinusoïde pour éliminer ces « effets de bord ».

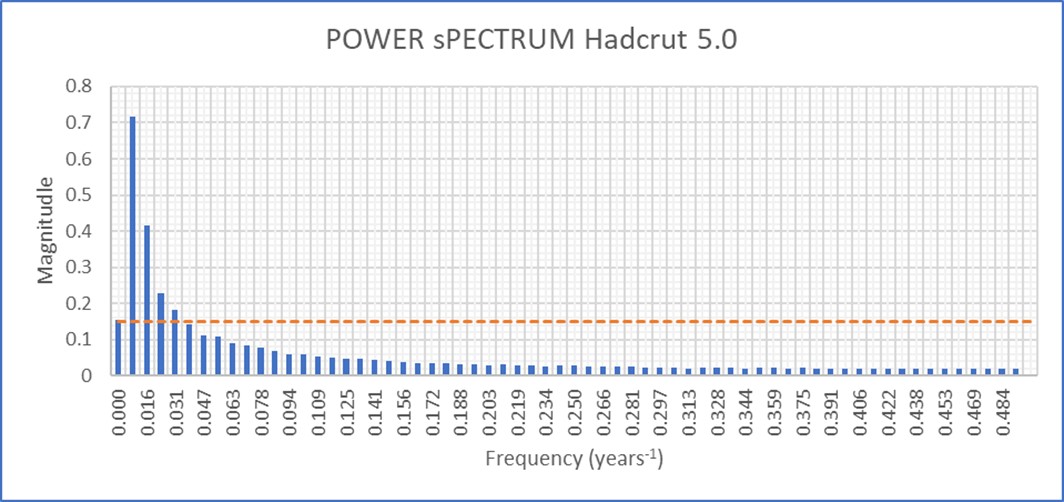

Malheureusement pour le GIEC, comme il a été mentionné au tableau 2 présenté plus haut, il existe une multitude de composantes cycliques dans les relevés de température, avec des périodes s’étalant d’un jour à plusieurs centaines de milliers d’années, comme une analyse du spectre de puissance (transformée de Fourier de la fonction d’autocorrélation) ou l’examen de scalogrammes le démontrent clairement. Et comme le GIEC utilise une fenêtre de mesure commençant en 1980, soit une fenêtre s’étendant sur une quarantaine d’années, le respect de la « règle des 6 périodes » évoquée ci-dessus est parfaitement impossible. Toutes les « projections » que le GEC annonce, exprimées sous forme d’augmentation de température par décennie ou par siècle (c’est-à-dire en termes de pente de droite de régression des anomalies de température), sont donc entachées d’un « effet de bord » qui permet de leur faire dire ce que l’on veut selon le début et la longueur de la fenêtre de mesure prise en compte.

De plus, Il convient de noter que ces cycles naturels ne sont pas exactement périodiques, traduisant un caractère légèrement chaotique du système climatique, ce qui empêche leur élimination complète par filtrage. Il est donc matériellement impossible de travailler avec une fenêtre de mesure respectant la « règle des 6 périodes ». Il est donc mathématiquement incorrect, dans ces conditions, de tracer une droite de régression dont la pente varie au gré des choix du moment initial et de la longueur de la fenêtre de mesure. Et pourtant, de la pente d’une telle droite de régression, le GIEC déduit des « projections » de l’augmentation de température « hautement probable » (sic) sur la décennie voire le siècle à venir.

Il est parfaitement irresponsable de construire des politiques climatiques, aussi dispensieuses que néfastes à léconomie et au bien-être des populations que l’on y soumet, car horriblement dispendieuses, en se basant sur la pente d’une telle droite de régression, parfaitement arbitraire en fin de compte. Et pourtant…

Régression linéaire des anomalies globales de température ?

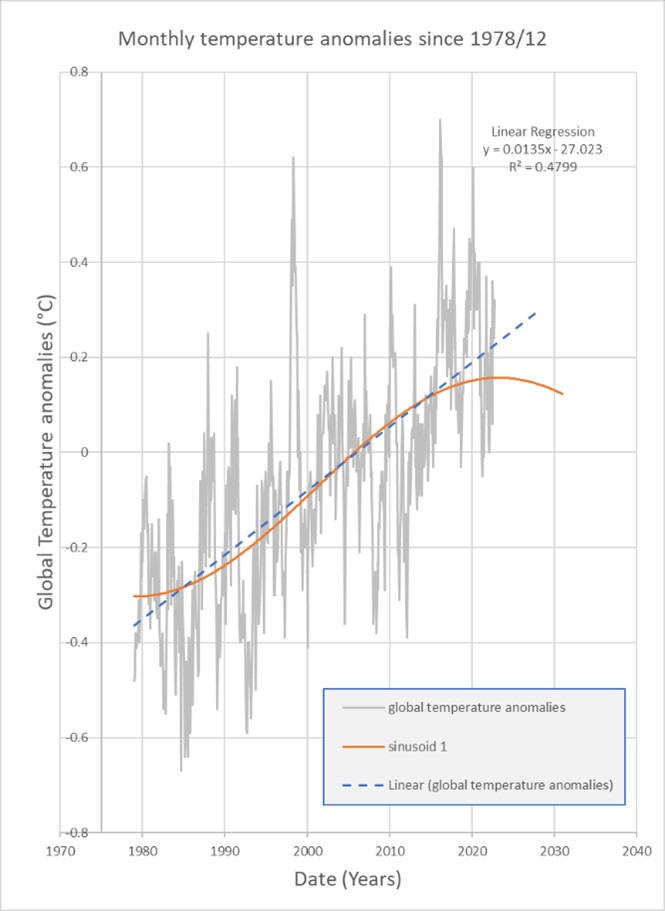

Malgré tout ce qui vient d’être rappelé, le relevé d’anomalies de température globale diffusé par la NOAA américaine et repris par le GIEC est approché par une droite de régression qui ne veut rien dire (ou à qui l’on fait dire ce que l’on veut, moyennant quelques ajustements judicieux de longueur ou d’instant initial de la fenêtre de mesure, comme nous l’avons montré).

Remarquons tout d’abord que la branche ascendante d’une sinusoïde de période égale à 84 ans, synchronisée à la fenêtre de mesure, ajuste les anomalies de température tout aussi bien, si pas légèrement mieux, que la droite de régression ; mais une sinusoïde présente l’avantage d’être extrapolable de façon plus réaliste vers le passé et donc aussi, vraisemblablement, vers le futur qu’une droite de régression (cfr. figure ci-dessous).

Il est en effet évident, lorsqu’on regarde vers le passé, que la température n’a pas continué à descendre uniformément, mais qu’il y a eu une succession d’épisodes froids et chauds. Tout le monde a entendu parler de l’optimum romain et de l’optimum médiéval, ainsi que des mini-périodes glaciaires de Maunder (au cours de laquelle on tenait marché sur la Tamise gelée) et du minimum de Dalton au début du 19eme siècle. Symétriquement, en se projetant vers l’avenir, on peut remarquer que la « pause » (ou « le hiatus ») observée dans l’augmentation des anomalies de température globale depuis près de 20 ans peut très simplement s’expliquer comme correspondant au passage de la sinusoïde par son maximum, ce qui implique que l’on s’oriente non pas vers un réchauffement, mais vers une diminution de température dont les prémices sont dès lors déjà observables à partir des données les plus récentes.

Finalement, il convient de remarquer que la courbure propre à une branche ascendante de sinusoïde, associée à un choix non anodin de la longueur et de l’instant initial de la fenêtre de mesure, peut engendrer l’idée fausse que le réchauffement climatique s’accélère (si l’on prend soin d’interrompre l’analyse avant l’apparition de la « pause »), comme illustré ci-dessous (Figure 25). Le GIEC est tombé dans ce piège, ou peut-être l’utilise sciemment, faisant croire ainsi qu’il y a accélération du changement climatique, et donc urgence à (tenter de) le contrôler, en le finançant à grands coups de taxes plus ou moins déguisées et dites vertueuses d’une part, et d’autre part à coups de généreux subsides aux « escrolos de service » et de transferts financiers collossaux vers les pays en voie de développement.

La façon correcte de procéder

L’ajustement de séries temporelles, que ce soit par une droite, une ou plusieurs sinusoïdes ou toute autre fonction, doit obéir à certaines conditions, souvent négligées, pour être statistiquement valable. Parmi celles-ci, un certain nombre concerne le résidu de l’ajustement. Celui-ci doit :

- Ne plus contenir d’information

- Être stationnaire : (ne pas croître ou décroître en fonction du temps)

- Ne plus contenir de composantes périodiques significatives

- Être assimilable à un bruit blanc

- Être réparti autour de la courbe de régression selon une distribution normale

- Avoir une fonction d’autocorrélation comparable à celle d’un bruit blanc

- Respecter l’homoscédasticité (avoir une dispersion homogène tout au long de la courbe de régression).

Pour les besoins de la cause, et malgré toutes les critiques formulées dans ce travail à l’encontre des anomalies globales de température, appliquons ces critères à l’ajustement des données HADCRUT 5.0.1.0 annuelles, collationnées par le MET anglais, précisément parce qu’elles sont utilisées par le GIEC ; et utilisons ces données pour évaluer la qualité de leur ajustement par une droite de régression (comme le fait le GIEC lorsqu’il parle d’une augmentation de température moyenne globale de quelques degrés par siècle). A titre de comparaison, évaluons également la qualité de l’ajustement obtenu avec une somme de sinusoïdes, ajustement dont la pertinence sera dévoilée au cours de l’analyse qui suit.

Les données Hadcrut 5 et leur ajustement

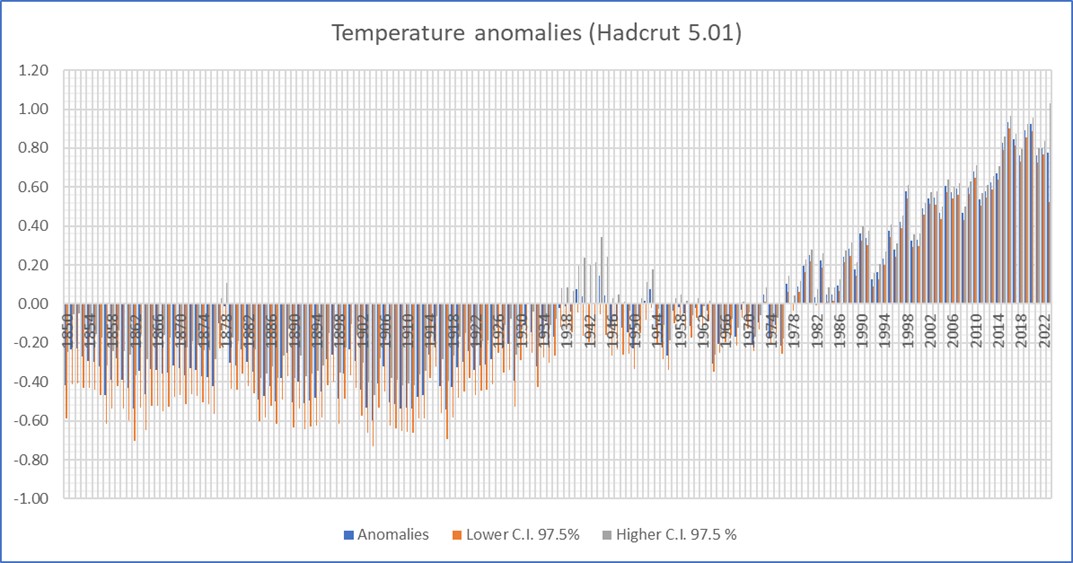

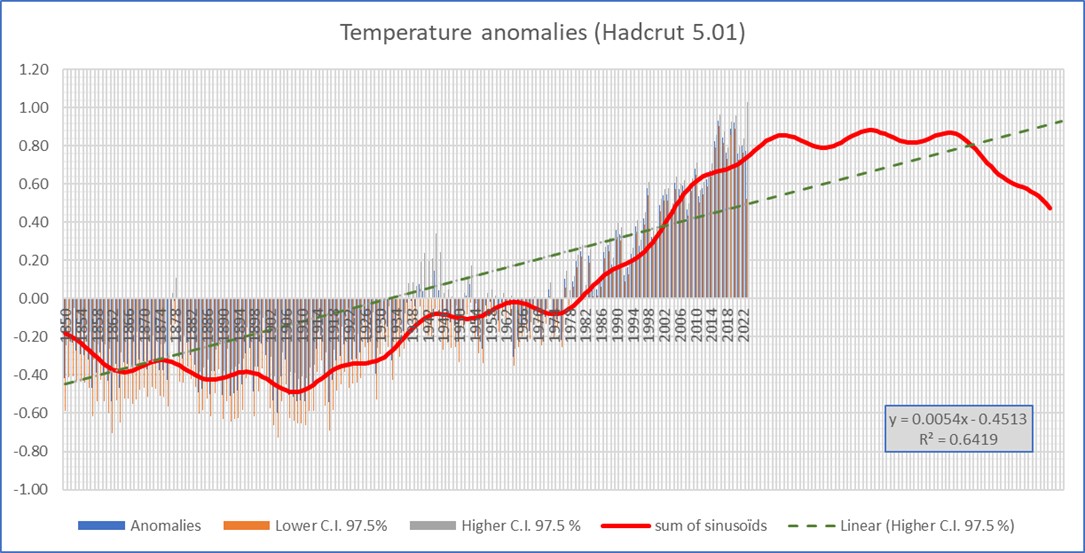

Les données Hadcrut 5.0 annuelles depuis 1850 ont été portées en graphique ci-dessous (Figure 26). Il s’agit des données les plus récentes disponibles à ce jour.

En principe, cette figure est identique à la figure 25, construite avec les données de 2001. Le lecteur appréciera l’ampleur des ajustements effectués sur les températures du passé, ajustements pas toujours correctement documentés et encore moins justifiés de façon convaincante (Figure 27).

Le spectre de puissance (transformée de Fourier de la fonction d’autocorrélation) de ces données révèle l’existence d’une composante continue (fréquence zéro) et de quelques périodicités de magnitude supérieure à celle de la composante continue. C’est cette observation qui a justifié le choix d’approcher la courbe empirique par une somme de sinusoïdes.

Ajustement des données Hadcrut 5.0

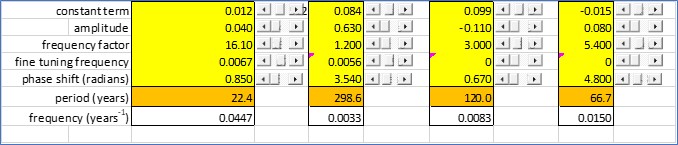

La figure 29 ci-dessous présente les données HADCRUT 5.0.1 annuelles depuis 1850, et leur ajustement par une droite de régression et par une somme de 4 sinusoïdes dont les paramètres sont donnés au tableau ci-dessous. Ces paramètres ont été définis (Tableau 3) par optimisation non linéaire de la somme des carrés des écarts (SSE) qu’il convient de minimiser.

Remarquons au passage que l’extrapolation de l’approche sinusoïdale prévoit une stagnation des températures, fluctuant légèrement pendant deux à trois décennies autour de la valeur actuelle, avant de décroitre à partir de 2050, et cela sans aucune intervention humaine. La régression linéaire prévoit quant à elle une augmentation continue de température, de l’ordre de 0.5°C par siècle, sans aucune intervention humaine ; ce qui laisserait malgré tout 4 siècles avant d’ atteindre les deux degrés fatidiques au-delà desquels les alarmistes prédisent (sans aucune justification rationnelle) des catastrophes climatiques irréversibles.

Il n’y aurait donc aucune urgence climatique, quelle que soit l’approche suivie.

Qualité d’ajustement

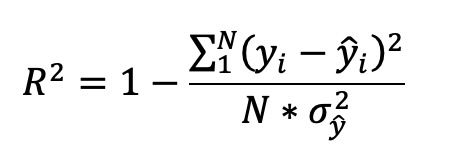

La qualité d’un ajustement de séries temporelles se fait usuellement en comparant les sommes des carrés des résidus d’ajustement (SSE Sum of Squared Errors), qu’il convient de minimiser. Comme cette somme dépend du nombre de points de mesure, lorsque les séries temporelles que l’on veut comparer sont de longueur différente, on préfère utiliser le coefficient de détermination R² qui y est lié par la formule suivante :

Dans cette formule,

N représente le nombre de points de la série temporelle

yi les valeurs contenues dans la série temporelle

ŷ les valeurs ajustées correspondantes

σ2 la variance des données contenues dans la série temporelle

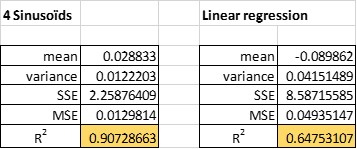

R² mesure le pourcentage de variance totale des données qui est expliqué par leur ajustement. Comme indiqué dans le tableau ci-dessous, dans le cas présent, l’ajustement par 4 sinusoïdes conduit à une valeur de R² = 0.91, celle de la régression linéaire = 0.65.

Ce résultat n’a rien de surprenant, dans la mesure où l’ajustement par 4 sinusoïdes fait usage de 12 paramètres (4 fois une amplitude, une fréquence et un déphasage initial), tandis que la régression linéaire n’en utilise que deux. Il est à remarquer que l’adjonction d’une 5eme sinusoïde au modèle sinusoïdal n’ajouterait qu’un gain marginal de qualité. On parlerait alors de surdimensionnement paramétrique.

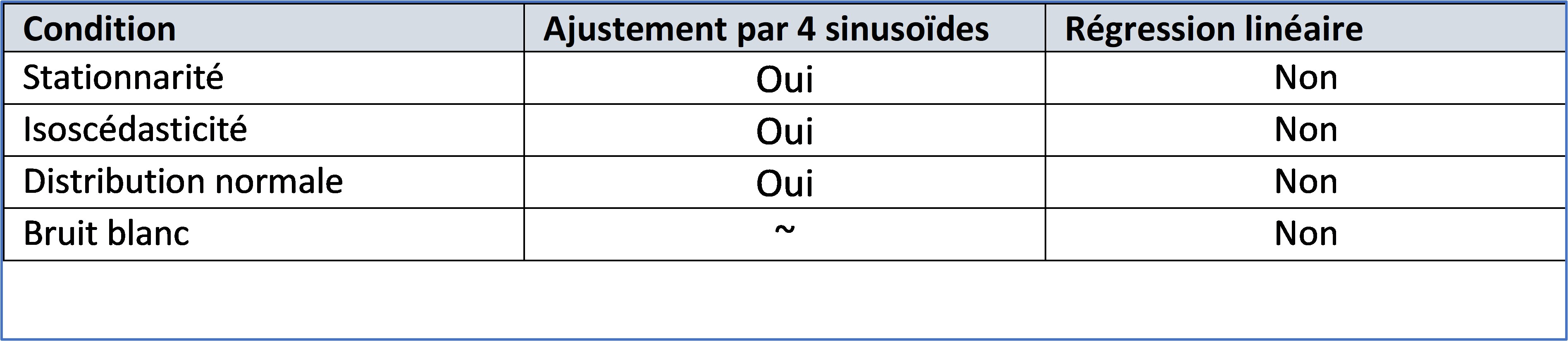

Vérification des conditions d’application des méthodes d’ajustement.

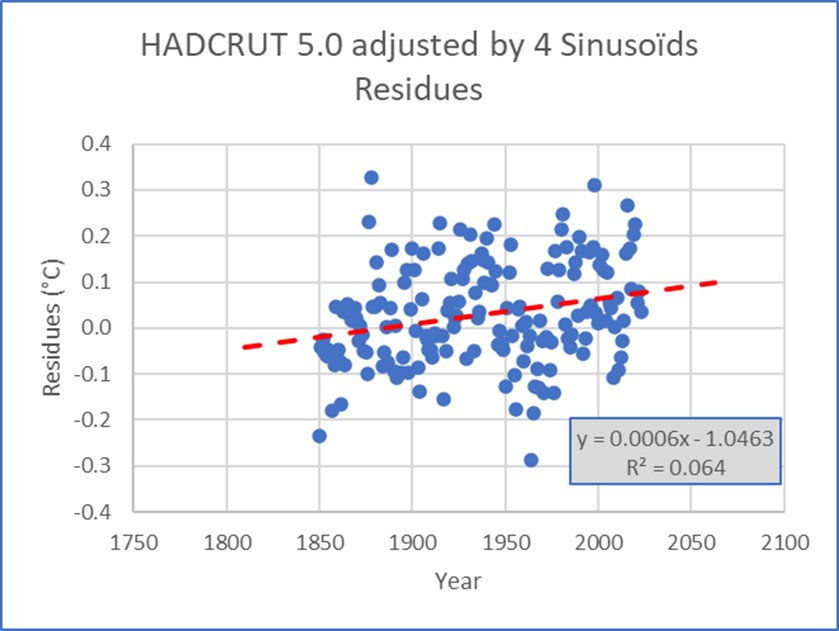

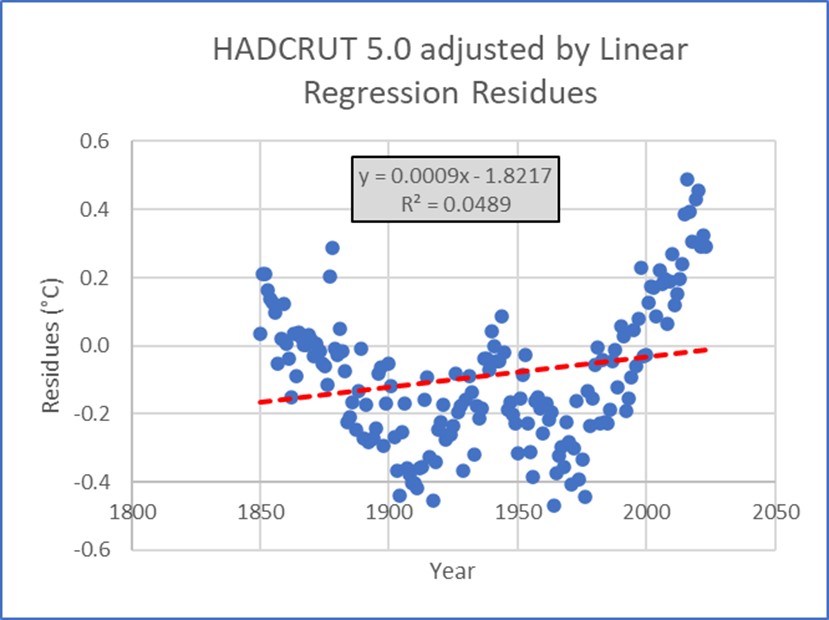

La première vérification est purement visuelle et consiste à examiner l’évolution des résidus en fonction du temps. Rappelons que ceux-ci doivent être

- Stationnaires sans tendance croissante, décroissante ou fluctuante en fonction du temps

- Distribués symétriquement autour de zéro, faute de quoi l’ajustement introduit un biais

- Dispersés de façon homogène (sans fluctuation de dispersion) autour de leur moyenne nulle au fil du temps

La figure 30 ci-dessous montre que les résidus correspondant à l’ajustement par 4 sinusoïdes vérifient à peu près ces trois conditions ; ce qui n’es pas le cas pour les résidus de la régression linéaire.

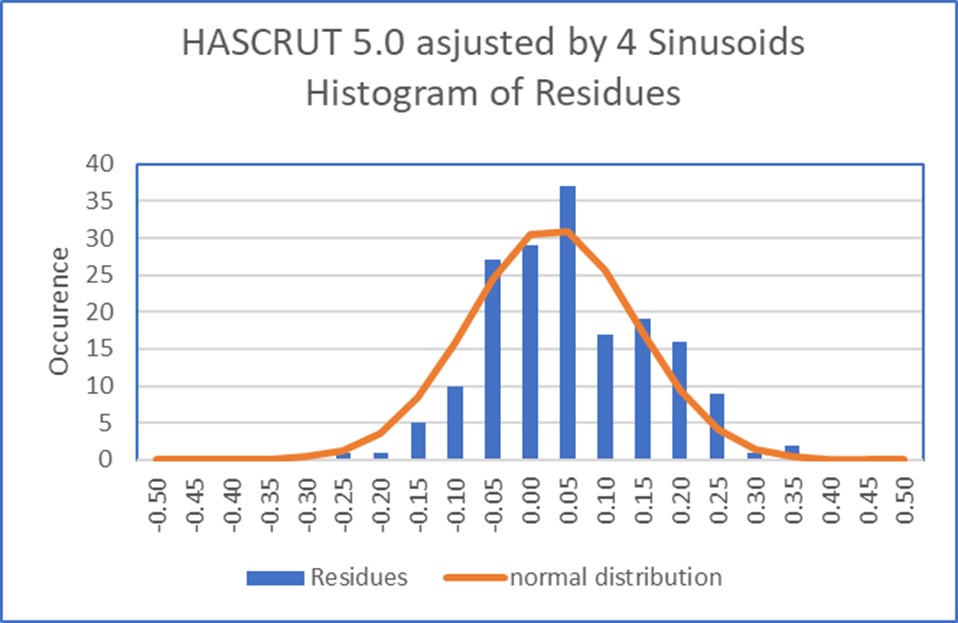

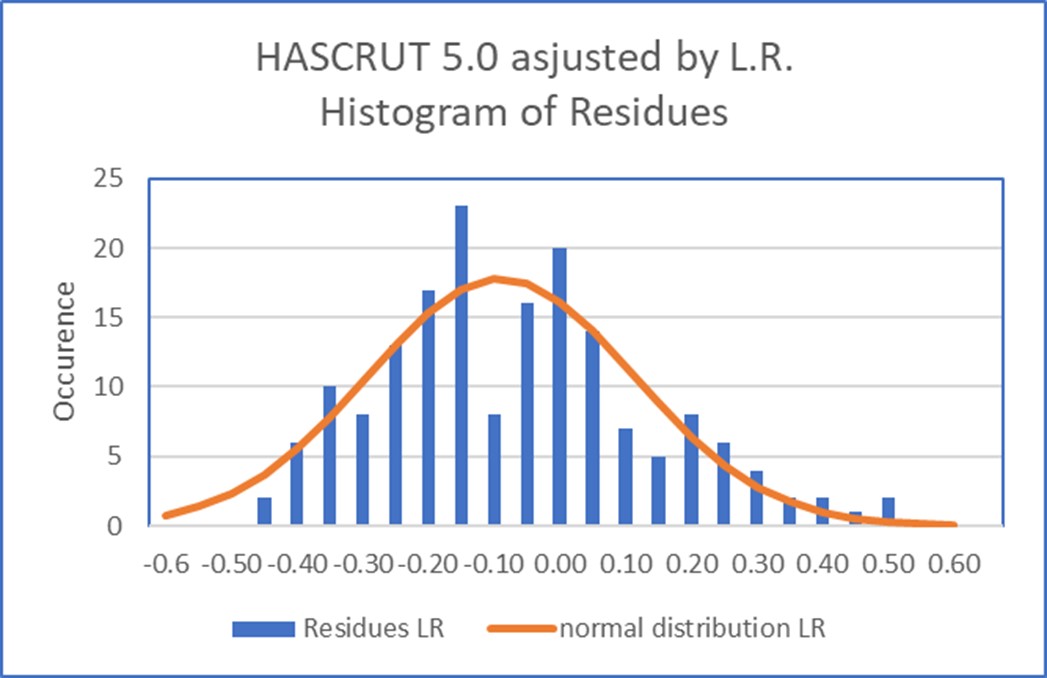

Le deuxième critère de qualité d’ajustement porte sur la distribution des amplitudes des résidus, qui, idéalement, doivent suivre une distribution normale. Visuellement, cela peut se juger, comme illustré sur la figure ci-dessous, en construisant un graphique superposant à l’histogramme des résidus une distribution normale de même moyenne et de même écart-type. On constate ici aussi que la distribution des résidus de l’ajustement sinusoïdal est plus proche de la courbe théorique que la distribution des résidu de la régression linéaire, qui de plus est nettement bimodale dans le cas présent.

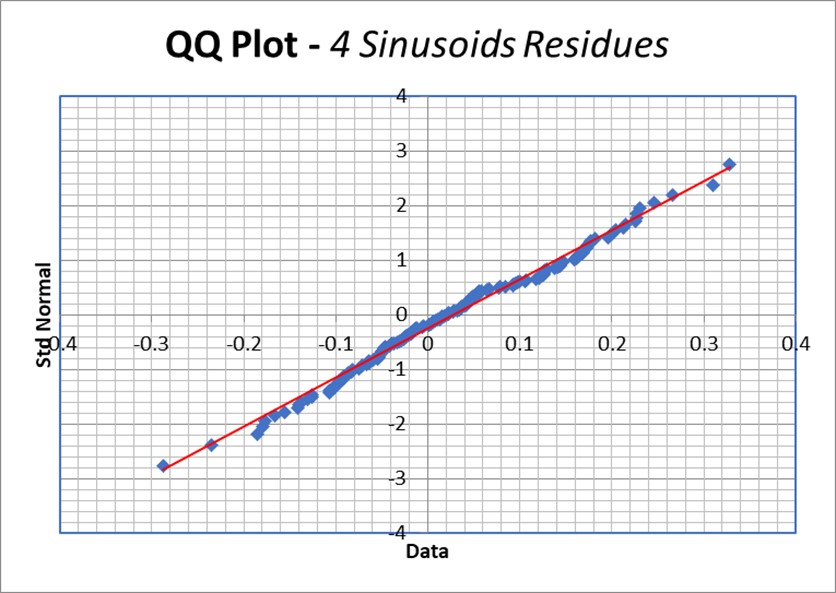

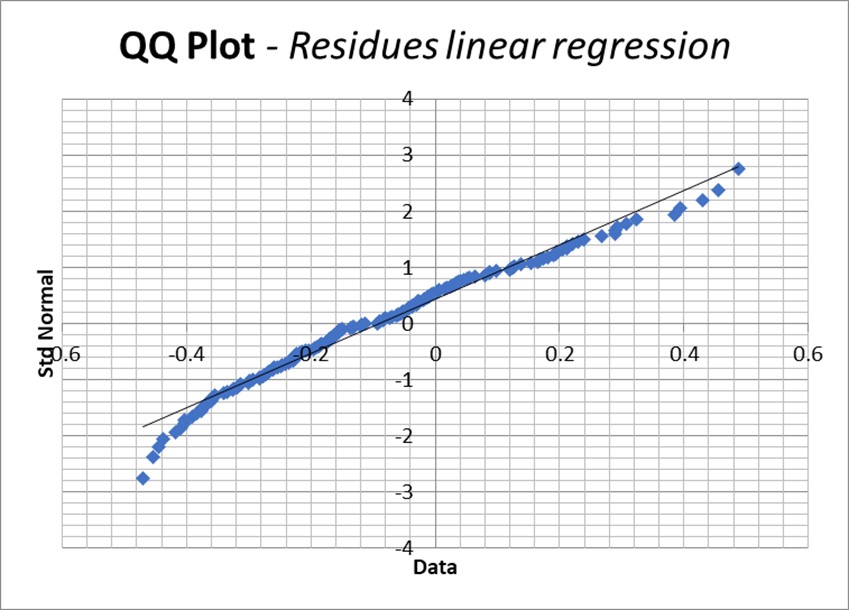

Une autre approche visuelle consiste à construire un diagramme QQ, dans lequel on porte en ordonnée les déciles ou centiles (divisant la population de points en 10 ou 100 parties égales respectivement) de la distribution normale et en abscisse ceux de la distribution des résidus. Idéalement les points devraient s’aligner parfaitement sur la diagonale ascendante de la figure.

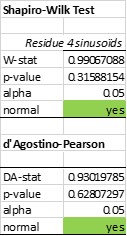

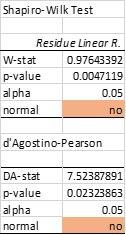

On peut aussi avoir recours à l’un des nombreux tests d’hypothèses existant pour tester la conformité à une distribution normale. Parmi ces tests, ceux de Shapiro-Wilkinson et de d’Agostino-Pearson sont parmi les plus performants. L’ajustement sinusoïdal passe les deux tests, tandis que l’ajustement par régression linéaire échoue aux deux (Tableau 5).

Tableau 5. Deux Tests de conformité à une distribution normale. A gauche, la distribution des résidus de l’ajustement sinusoïdal. A droite la distribution des résidus d’une régression linéaire. Les résidus d’ajustement sinusoïdal des données Hadcrut passent les deux tests, au contraire des résidus liés à l’ajustement linéaire.

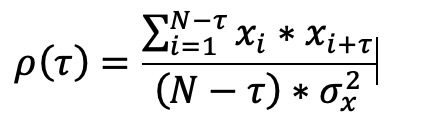

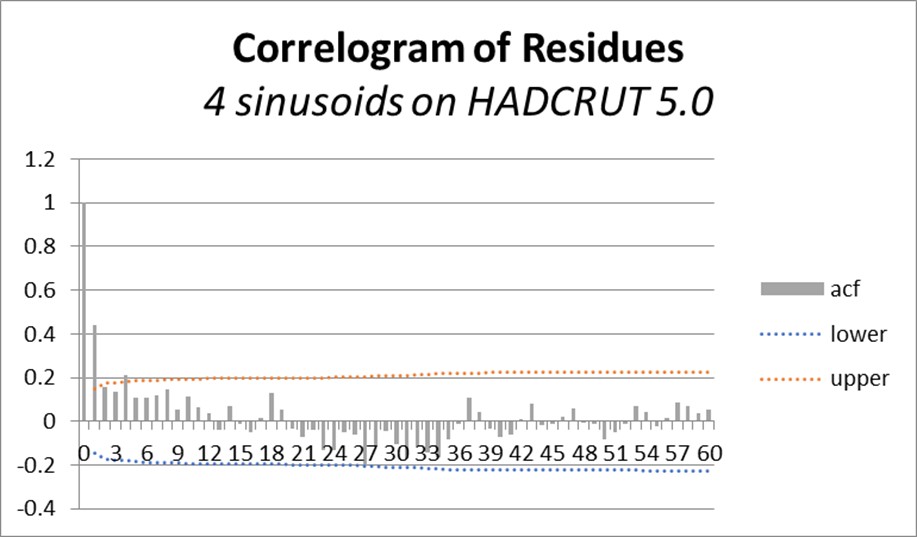

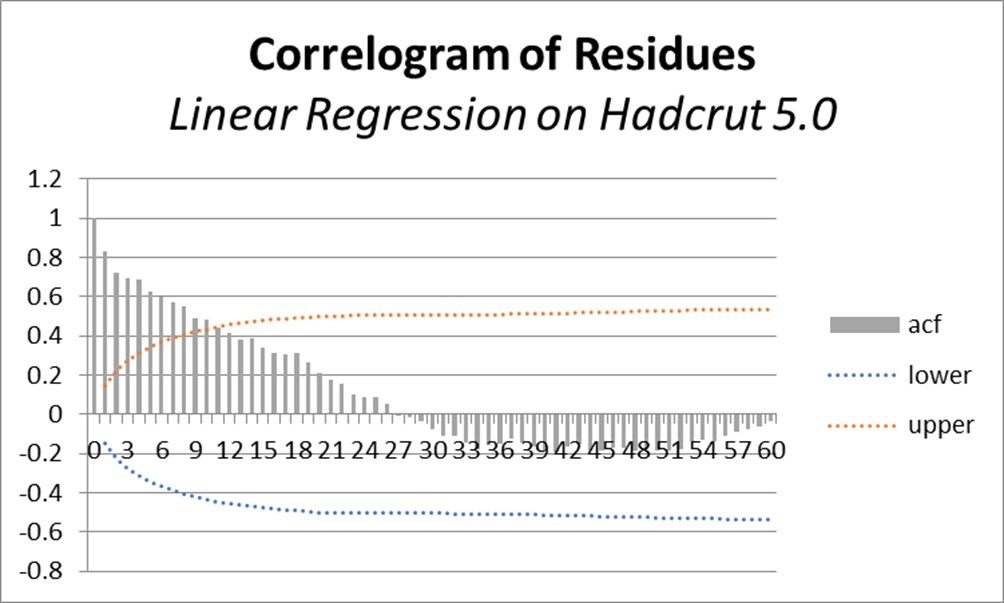

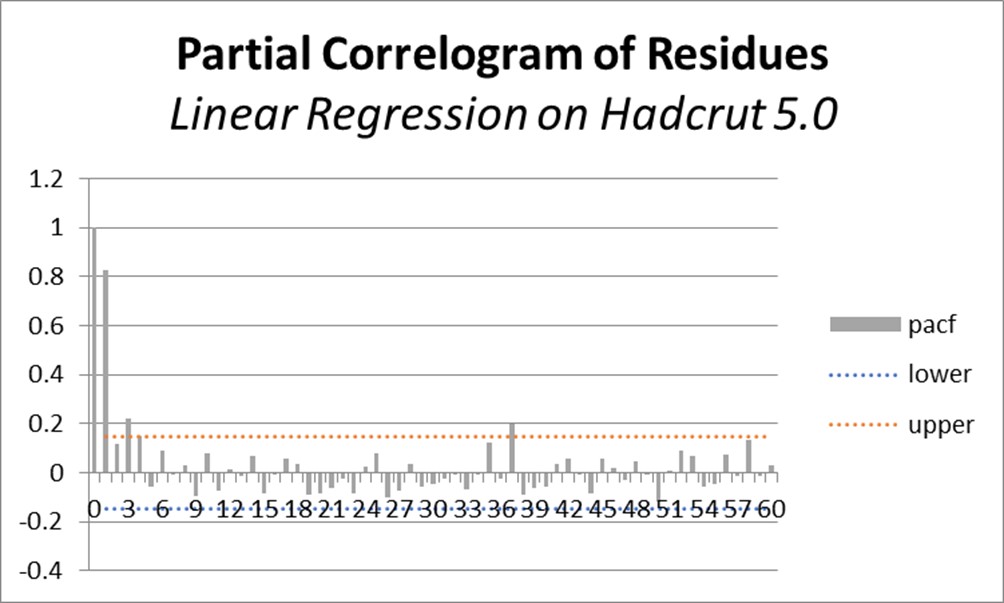

Le dernier point consiste à vérifier si les résidus sont assimilables à un bruit blanc. Une façon courante d’effectuer cette vérification consiste à examiner les fonctions d’autocorrélation et d’autocorrélation partielle des résidus d’ajustement et de comparer les résultats aux intervalles de confiance (à 95%) d’un bruit blanc (Cfr. Figure 33 ci-dessous)

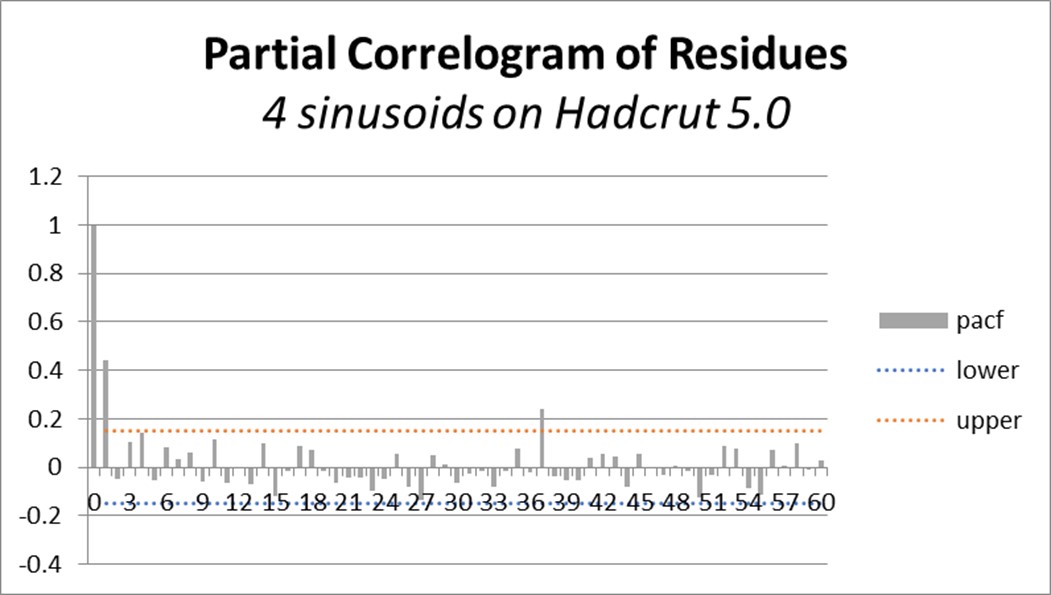

Pour rappel, la fonction d’autocorrélation correspond à la formule :

Dans laquelle N est le nombre de données xi de la série temporelle, τ le décalage et σ2 la variance.

Ici encore, l’ajustement par 4 sinusoïdes passe plus ou moins convenablement le test, alors que les résidus de l’ajustement linéaire échouent largement.

Les résultats de l’analyse de résidus effectuée sont résumés dans le tableau ci-dessous :

Tableau 6. Synthèse de l’analyse de conformité aux conditions requises

Le verdict est sans appel : aucune des conditions de validité d’un ajustement de série temporelle n’est respecté par une droite de régression appliquée aux données Hadcrut 5.0. Ce constat implique aussi et surtout que toute extrapolation d’une régression linéaire appliquée aux données Hadcrut 5.0 est statistiquement prohibée. Et pourtant…

Avant de conclure, et pour désacraliser définitivement le concept d’anomalies de température, on peut constater qu’elles ne sont, en fait, rien d’autre que le résidu de l’ajustement des données de température par une technique de « projection vraiment rudimentaire » : on examine le résidu d’un ajustement des données par la moyenne calculée sur une période fixe de 30 ans, se terminant au début de la fenêtre de mesure, qui se développe elle-même sur une durée de 30 ans, avant d’être réinitialisée. Il ne s’agit même pas d’une technique simple de moyenne mobile, puisque la période de référence « ne suit pas » le point de mesure. Et évidement ce résidu ne respecte pas les conditions décrites ci-dessus. On ne peut donc qu’en déduire que l’utilisation d’anomalies de température est une mauvaise technique d’ajustement des températures, non validée statistiquement, et rien de plus.

Conclusions

Les données locales provenant de stations météo, de relevés de température en mer (que ce soit par empotement, mesure de température d’eau de refroidissement des moteurs ou par bouées) ou par satellites sont entachées d’erreurs de mesure et de calibrage qui ne les rendent pas totalement compatibles entre elles, et encore moins propres à déceler d’infimes variations de température d’année en année, qui se confondent avec les croix d’erreur expérimentale.

Outre le fait qu’il n’a aucun sens physique ni géographique, le concept d’anomalie globale de température soufre d’un manque de représentativité spatiale et temporelle, et engendre de fausses tendances et des biais en présence de composantes cycliques dans les données brutes. Il est donc fortement déconseillé d’utiliser les anomalies de température pour tenter de justifier l’une ou l’autre mesure de politique climatique.

D’autre part, les conséquences climatiques sont locales. Le GIEC base ses projections, justifiant ses recommandations, sur des modèles à circulation globale, calibrés avec des anomalies globales de température. Ces modèles sont incapables de décrire les variations locales, même régionales de température, dans l’état actuel de leur développement et des capacités des super ordinateurs nécessaires pour effectuer les calculs longs et complexes qu’ils demandent.

Malgré ces critiques, et pour que l’analyse des pratiques du GIEC soit complète, la série temporelle HADCRUT 5.0.1 d’anomalies globale de température développée par le MET britannique, et largement utilisée par le GIEC pour calibrer ses modèles, a été analysée.

Cette analyse démontre clairement la légitimité statistique d’approcher les données climatiques annuelles HADCRUT 5.0.1 par une somme de 4 sinusoïdes, au contraire d’une régression linéaire qui enfreint la plupart des conditions de son applicabilité dans le cas présent, et qui conduit donc à des conclusions certes alarmistes, mais parfaitement non fondées.

Il convient bien sûr de se souvenir que, bien que cela soit pratique courante, rien ne dit que le meilleur ajustement de données existantes produit également la meilleure projection vers le futur.

Les extrapolations des données climatiques locales, la comparaison des diverses méthodes d’ajustement et de projection correspondant à « l’état de l’art (régressions multiples, décomposition, Arima, réseaux neuronaux, etc.)», la définition des intervalles de confiance de ces projections en tenant compte de la propagation des erreurs, la détection d’une signature chaotique éventuelle (par analyse dite non linéaire) et dans certains cas même les limites de l’horizon de prédictibilité (par diagramme de visibilité) feront l’objet d’une autre publication dans les prochains mois.

A chacun sa vérité, je ne cherche nullement à vous convaincre, mais à vous aider à réfléchir sur ce que l’on vous raconte à propos du climat, de façon critique, sur base de quelques considérations mathématiques somme toute élémentaires.

Figure 4 agrandie :

A lire également : Past and Present Warming – A Temporal Resolution Issue.

excellente étude

requiert cependant une connaissance mathématique du niveau minimum math-spé (bac + 3)

intérêt :

l’approche se base :

* ni sur une variation de production de co² (considéré comme le grand satan par le GIEC et consorts)

* ni sur « l’effet de serre » hautement sujet à caution dans son utilisation

Par contre cette étude témoigne d’une réelle approche scientifique :

*partir des données (réelles et non plus ou moins trafiquées)

*raisonner à partir des fluctuations décelées

*et déterminer les réelles variations sous-jacentes via des courbes de régression logiques

Trop long et trop technique, mais plusieurs constats m’ont ouverts les yeux.

Merci pour ces démonstrations.

Cet article commence par des affirmations fausses sur le manque de transparence et de sérieux scientifique du GIEC.

« Ces résumés, largement remaniés et expurgés politiquement par des représentants des divers gouvernements impliqués,…. Sans que jamais quelqu’un ne s’interroge sur le bien-fondé de la « science » ou sur la qualité des données expérimentales sur lesquelles tout l’édifice repose ».

Le GIEC a pour mandat d’évaluer, sans parti pris et de manière méthodique et objective, l’information scientifique, technique et socio-économique disponible en rapport avec la question du changement du climat. Ces informations sont synthétisées à partir des recherches ou études effectuées par des scientifiques, des experts ou des organismes et publiées dans des revues scientifiques.

Le GIEC travaille à dégager clairement les éléments qui relèvent d’un consensus de la communauté scientifique et à identifier les limites dans les connaissances ou l’interprétation des résultats. La compréhension des fondements scientifiques du changement climatique provoqué par l’homme doit permettre d’en établir les conséquences et d’envisager des stratégies d’adaptation et d’atténuation.

Le résumé pour décideurs est examiné puis adopté ligne par ligne par les représentants des gouvernements sous le contrôle des scientifiques, auteurs du texte initial.

Les rapports sont « réécrits » 3 fois tout au long d’un processus qui dure 2 ans. Un rapport d’évaluation c’est 2 000 à 3 000 pages s’appuyant sur des milliers d’études et prenant compte plusieurs dizaines de milliers de commentaires.

Ces milliers d’études s’interrogent justement sur la qualité des données et les méthodes employés.

Pour le vérifier, vous pouvez lire les articles référencés dans le dernier rapport du GIEC

Les commentaires dont il est question sont des commentaires effectués par des scientifiques extérieurs demandant plus de précision, des vérifications ou remettant en question les résultats/méthodes. Les experts du GIEC sont ainsi les premiers critiques de leur travail et les rapports finaux peuvent donc être pris avec sérieux et véracité.

Je rajouterai probablement des commentaires par rapport à la suite de l’article mais en attendant une lecture intéressante :

https://fr.in-mind.org/fr/article/les-causes-psychologiques-et-sociales-du-complotisme

En effet, la grande différence entre les théories du complots et les complots avérés est d’ordre méthodologique (Boltanski, 2012; Dieguez, 2018; Wagner-Egger et al., 2019). Les vrais complots sont mis à jour par des enquêtes et des preuves directes (aveux, documents, etc.) de la part d’enquêteurs professionnels (journalistes d’investigation, procureurs, lanceurs d’alerte professionnalisés sur un sujet particulier, etc.), tandis que les théories du complot ne sont justifiées que par l’existence de « données erratiques » (anomalies apparentes de la version officielle).

Je pense que votre commentaire est hors de propos par rapport à l’article auquel il s’adresse.

Le fait que vous vous focalisez sur une phrase introductive sans tenter d’évoquer le fond de l’article dénote, à mon avis, une sérieuse méconnaissance des sujets traités. C’est un des stratagèmes bien connus « de l’art d’avoir toujours raison (même quand on a tort décrits par Schopenhauer, il y a bien longtemps déjà». C’est passablement éculé, comme tactique.

En effet, je ne fais nullement le procès du GIEC, de ses méthodes et de son agenda. D’autres s’en sont chargés il y a bien longtemps déjà (par exemple la journaliste Donna Laframboise, « The delinquent teenager », ou le philosophe Drieu Godefridi, « Le GIEC est mort vive le GIEC »)

Ne voulant cependant pas esquiver vos commentaires d’un revers de main, je vous répondrai donc précisément, mais aussi brièvement que possible :

1- le GIEC fonctionne bien comme je l’énonce : les groupes thématiques, constitués par cooptation sélective, effectuent un travail de compilation tout aussi sélective (uniquement à charge du CO2 anthropique, ce qui constitue un non-sens du point de vue de l’analyse systémique, le climat étant complexe et non linéaire, les effets ne font pas que s’ajouter en totale indépendance ; mais ceci est un autre débat) et produisent un rapport pour décideurs qui est relu ligne par ligne et modifié par consensus par les délégués politiques, avec pour mission pour les groupes de travail de nettoyer ultérieurement leur version initiale afin de la rendre cohérente avec le résumé politique. Ce sont donc bien les politiques qui ont le dernier mot et pas les scientifiques comme vous le suggérez.

2- les différentes versions draft sont en effet, comme vous le mentionnez, soumises à critique, mais, à l’expérience, l’essentiel des critiques « divergentes » est éliminé d’office par les groupes de travail qui pratiquent donc, de fait, un auto-audit biaisé. C’est la seule agence internationale qui pratique ce genre d’exercice, les autres évitent d’être à la fois juge et partie. A titre d’information, sachez que je suis correspondant de l’IEG (Independent Evaluation Group) auditant l’exécution des programmes de la Banque Mondiale ; je crois donc pouvoir dire que je parle en connaissance de cause.

3- une activité scientifique ne se développe pas par consensus parmi les auteurs d’un rapport donné (encore heureux qu’ils s’accordent sur ce qui est écrit sous leur nom !), d’autant plus que ceux qui défendent une position hétérodoxe quittent ou sont invités à « quitter le navire ».

4- une véritable activité scientifique, digne de ce nom, prend en compte les différentes théories ou approches formulées, en particulier si elles s’opposent fondamentalement (dans le cas présent il s’agit du rôle prépondérant ou non du CO2 anthropique dans le dérèglement climatique) et une telle démarche requiert qu’on en fasse un examen critique. Le GIEC ne le fait pas, et ses suppôts font taire toute voix dissonante en compliquant singulièrement, pour les auteurs « indépendants du GIEC », l’accès aux revues scientifiques, dont les « giecistes » contrôlent largement, au fil du temps, les comités de lecture ; ils pratiquent également la « cancel culture » et le « bashing » dans les institutions de recherche, au mépris de la célèbre citation de Poincaré : « La Pensée ne doit se soumettre à aucun Dogme, aucune Idée préconçue, car pour elle se soumettre c’est cesser d’exister » et à cette autre citation attribuée à Voltaire (qui semble être « fake » en fait) : « je ne partage pas vos idées, mais je me battrai jusqu’à la mort pour que vous puissiez les exprimer ». Ce sont là des valeurs qui me sont chères, et c’est la raison pour laquelle je suis membre de l’Heterodox Academy, une institution visant à maintenir voire à rétablir la liberté de pensée dans le monde académique. Et oui, l’opposition à la « cancel culture » s’organise. Par ailleurs les institutions de recherche sont en permanence à la recherche de subsides, elles ne se risquent pas à rendre publique des thèses allant à l’encontre de la doxa gouvernementale, européenne ou onusienne. C’est une des raisons pour lesquelles la plupart des climato-réalistes sont des professeurs émérites, n’ayant plus rien à prouver, parfaitement indépendants, incontrôlables et qui ne sont pas devenus séniles ou déments du jour au lendemain. Que du contraire ; débarrassés des tâches administratives et d’enseignement, ils ont tout le temps de se livrer à des activités de recherche, en groupe via des réseaux sociaux spécialisés, tout en étant nantis d’un bagage méthodologique que les jeunes chercheurs n’ont pas encore eu le temps d’acquérir, sans évoquer l’esprit critique de ces émérites, esprit critique aiguisé par des années de supervision et d’évaluation de thèses et de rapports scientifiques. « OK boomer » n’est vraiment pas de mise dans ce cas précis.

5- un groupe de 1500 scientifiques (clintel.org), tout aussi respectables que les membres des groupes de travail du GIEC (certains étant des professeurs climatologues émanant d’institutions prestigieuses et étant même lauréats de prix Nobel), s’est constitué comme entité indépendante auditant les travaux du GIEC. J’en suis le vice-président en charge de l’analyse et du traitement de données, un thème sur lequel je travaille au niveau école doctorale depuis de nombreuses années (que les données soient climatiques, économiques, géopolitiques, socio-économiques, financières, épidémiologiques, etc.). Ceci dit sans vouloir utiliser un quelconque argument d’autorité vis-à-vis de quelqu’un qui communique anonymement, et hors de propos.

Quant à votre tirade sur le complotisme, je ne comprends pas très bien sa place dans votre argumentation à l’encontre d’un texte qui ne fait qu’auditer la qualité et le traitement de données utilisées par le GIEC, audit effectué avec des méthodes qui devraient être compréhensibles par quelqu’un ayant un minimum de connaissances mathématiques et statistiques. Je serais ravi d’avoir vos commentaires sur le fond de cet article, si possible. Vous évoquiez aussi le « debunking » d’informations complotiste (encore faut-il que le vérificateur soit à la fois vraiment compétent et indépendant ; et là j’ai des doutes après avoir dirigé une thèse de doctorat sur le sujet, la candidate étant une journaliste d’Al Jazeera). Mais si pour vous le « fact-checking» d’une information passe, par exemple, par des aveux, lisez ou écoutez ce que disent les dirigeants de l’ONU, son secrétaire Général en tête, sur la réelle finalité du GIEC et des entités qui l’englobent (jusqu’au niveau de l’UNEP). L’agenda est bien politique : culpabiliser les pays occidentaux et les ébranler par des arguments émotionnels du style « n’avez-vous pas honte de votre passé colonial durant lequel vous avez spolié vos anciennes colonies ? », « il y a urgence, il faut sauver la Planète », « quel monde pourri allez-vous laisser à vos enfants ? », etc ; et cela afin que lesdits pays occidentaux consentent plus facilement à verser des fonds vers les pays en développement, ou qui ne le sont plus vraiment comme les BRICs, tout en sabordant leur compétitivité et indépendance énergétique, technologique et alimentaire. Il faut aussi se rappeler que 1- ce que l’on qualifie de faire preuve de complotisme, en novlangue, n’est rien d’autre que ce que l’on appelait précédemment faire preuve d’esprit critique et systémique, des qualités prisées pour des scientifiques. 2- l’accusation de complotisme est la première ligne de défense de l’establishment pris « la main dans le sac ». 3- et que quand on est lanceur d’alerte un quart d’heure avant les autres, on a tort (et on est accusé de complotisme) pendant 15 minutes.

Pour aller plus loin dans la ‘réalité’:

U.N. Official Reveals Real Reason Behind Warming Scare

https://www.investors.com/politics/editorials/climate-change-scare-tool-to-destroy-capitalism/

https://principia-scientific.com/the-hidden-agenda-behind-climate-change/

Bravo monsieur Masson 👏

C’est une réponse parfaite, complète et argumentée à ce commentaire 👍

Traiter gratuitement les gens de complotistes, ou de « négationnistes » comme le fait Breon, ne rend pas faux notre discours et nos analyses.

Ce sont juste des tentatives de discréditer (debunk), sans vraiment apporter de contre-arguments recevables.

J’ai même vu récemment une propagande autour du Petit Âge Glaciaire sur une vidéo youtube faite par NotaBene, et qui explique que c’était local (hémisphère Nord) alors que même sur Wikipédia on a des preuves que ça touchait également l’hémisphère sud, et que cette période de 300 ans du Petit Âge Glaciaire n’était pas vraiment du Climat car trop court, alors que le réchauffement actuel depuis la fin du Petit Âge Glaciaire (170 ans) c’est du Climat.

Et les gens tombent dans le piège, et voilà comment on gomme cette période pour mieux retomber sur la courbe de Mann…

Bonjour Agathe,

J’aimerais apporter deux précisions à votre commentaire.

Quand vous citez la mission du GIEC, vous omettez les deux derniers mots à mon avis importants quant à l’orientation prise par cet organisme dès l’origine. Voici la description exacte et complète à l’origine :

« le GIEC a pour mission d’évaluer, sans parti pris et de façon méthodique, claire et objective, les informations d’ordre scientifique, technique et socio-économique qui nous sont nécessaires pour mieux comprendre les fondements scientifiques des risques liés au changement climatique d’origine humaine ».

Je vous concède que ces mots, encore cités en 2007, se sont évanouis par la suite.

https://www.actu-environnement.com/ae/dossiers/GIEC/mission_GIEC.php4

Lorsque vous dites :

« Le résumé pour décideurs est examiné puis adopté ligne par ligne par les représentants des gouvernements sous le contrôle des scientifiques, auteurs du texte initial. »

Il semble, d’après un participant à la rédaction de ce résumé, que les politiques tripatouillent ce texte en fonction des intérêts de leurs gouvernements respectifs et sans considération pour le rapport initial.

https://belgotopia.com/2014/06/24/la-primaute-du-politique-dans-les-rapports-du-giec/

Bien à vous

@ Madame Agathe : permettez quelques propos « sociologiques » ?

Votre logorrhée en forme de prosélytisme GIECien me rappelle une vieille tante convertie aux croyances d’une redoutable secte (dont je tairai ici le nom : il y en a plusieurs).

Croyance(s) promettant l’accès à un Au-delà paradisiaque « à condition de s’y soumettre, de souffrir, et de verser quelques émoluments terrestres » afin d’accéder à leurs trompeuses promesses !

A l’inverse, ma défunte tante risqua de brûler dans les feux de l’enfer.

Soit une métaphore, brillamment illustrée au XVe siècle par Jérôme Bosch, mais réactualisée pour nos temps du XXIe ?

Ayant perso une expérience de la « dynamique des GRANDES organisations » et leur complexité intrinsèque (lisez donc The Structuring of Organizations de Henry Mintzberg ?, travaux de Crozier et Friedberg, etc., etc.), une analyse des réseaux du GIEC et leurs ‘sponsors’ devrait vous inciter à plus de retenue et à un sain décryptage de leurs « zones d’incertitudes respectives »… dès lors que les motivations d’une vaste foule d’acteurs y sont diverses et bourrées de contradictions.

Ainsi, votre réécriture de « Un rapport d’évaluation c’est 2 000 à 3 000 pages s’appuyant sur des milliers d’études et prenant compte plusieurs dizaines de milliers de commentaires. » doit laisser non seulement des milliers de ‘lecteurs compétents’ perplexes et dubitatifs ! Sauf bien sûr ceux d’entre eux (d’entre vous ?) convaincus de détenir une immuable vérité ?

A propos d’une interprétation sémantique « rigoureuse » desdites 2000-3000 pages et commentaires, certains de mes amis versés dans la traduction de textes sourient de vos candides affirmations. Ils ne parlent pas ici des versions de textes de la bible, mais plutôt de ceux mêlant science et politique…

Laissez donc, chère Agathe, les allusions « de complotisme » aux cercles de journalistes incompétents ou tendancieux ?

Le soi-disant « consensus scientifique » dont se targuent sans cesse les porte-voix du GIEC n’existe pas. Plus de 100 études publiées sur l’effet du CO2 sur la température concluent en majorité à son effet nul. Les autres à un effet faible.

https://www.laquestionclimatique.org/40-consensus.htm

La politique d’une idéologie de la décroissance essaye désespérément de nous entraîner vers son utopie.

Une quinzaine de pétitions cosignées par plus de 60.000 scientifiques ( dont plusieurs Nobel en Sciences), liés de près ou de loin à « L’Affaire Climat », un tel nombre de contestataires devrait au moins ouvrir un débat qui reste toujours interdit. Pourquoi ?

Une députée suisse a déposé un projet de loi visant à considérer le « négationnisme climatique » comme un crime !

Là ou la politique et la religion domine, la science n’a plus sa place.

Certainement que tout est mathématiquement faux avec ce GIEC. J’utilise un SIG qui me permet de cartographier la significativité des tendances locales. Le calcul est simple. Disons qu’on travail avec une série mensuelle de la température. Pour une valeur locale mensuelle supérieure à la valeur du mois qui la précède, on lui assigne la valeur 1. Inversement ce sera la valeur -1. Suite à une série temporelle recalculée de la sorte, on calcule la moyenne des valeurs mensuelles 1, 0 , -1 et on divise par l’écart-type pour chaque localité. Ça donne une valeur qu’on appelle le Z-score. C’est le Z-score qu’on cartographie. J’ai fait cette exercice pour la série UAH. C’est fou ce qu’on peut apprendre sur la température à l’échelle de la planète avec ce type de carte. Rien à voir avec les cartes qu’on nous sert.

» Comme développé dans l’article, moi aussi je pense qu’il convient de travailler avec des températures locales pour éviter des biais et fausses tendances, d’autant plus que les fluctuations climatiques ne sont pas synchronisées au niveau planétaire ; pendant un laps de temps déterminé, certaines régions se réchauffant alors que d’autres se refroidissent et d’autres encore enregistrent une température invariable.Et les tendances changent d’une fenêtre temporelle à l’autre. Calculer des moyennes spatio-temporelles dans ces conditions revient donc à gommer ces fluctuations naturelles qui sont cependant plus importantes que d’éventuelles contributions anthropiques.

Or, les conséquences de fluctuations climatiques sont locales et la résolution des modèles globaux comme ceux utilisés par le GIEC n’ont pas une résolution suffisante pour identifier des fluctuations locales, faute des limites de capacité actuelle des super-ordinateurs, et ceci sans même devoir évoquer la crédibilité des hypothèses sous jacentes (et souvent implicites) à ces modèles, l’hypothèse d’un effet de serre atmosphérique significatif dû aux activités humaines en tête. Ou encore sans devoir évoquer que les équations de Navier-Stokes en coordonnées sphériques donnent des résultats chaotiques lorsqu’on les intègre avec un algorithme de Runge-Kutta, ce qui signifie toute une série de projections différent fortement les unes des autres, au sein desquelles on peut choisir (« cherry picking ») celle qui convient le mieux à ses idées préconçues, tout en masquant soigneusement les autres projections « qui dérangent ». On est assez loin d’une méthode scientifique rigoureuse là.

Quant à distribuer les données de températures dans 3 clusters +1, 0, -1 c’est équivalent à la représentation visuelle de la figure de Eckwert (Figure 4 de l’article), mais vous perdez de l’information. Je préfèrerais calculer la variable z sur les températures que sur les fréquences d’appartenance à l’un ou l’autre des clusters de donnée que vous évoquez »