par Alain Préat, Professeur émérite de l’Université Libre de Bruxelles

SCE a plusieurs fois abordé la curieuse notion d’une « température moyenne globale annuelle ou mensuelle » pour la planète (voir notamment ici). Rappelons d’entrée de jeu que la température est une grandeur intensive (voir par exemple ici) qui est par essence définie localement. Moyenner ces valeurs locales n’a donc pas de sens (ici), comme le souligne le Professeur Richard Lindzen qui se demande par exemple comment estimer une température moyenne, entre l’Everest et la Mer Morte (cf. la double photo ci-dessous).

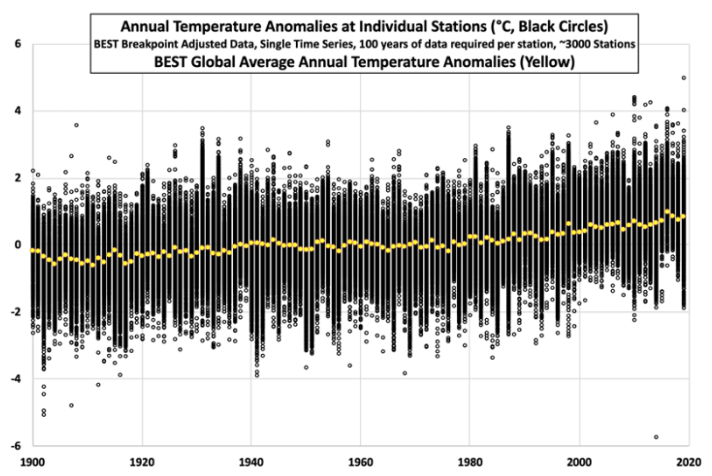

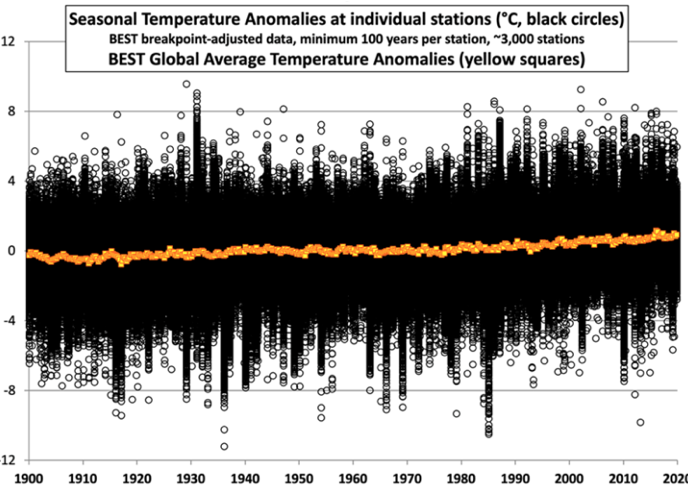

Récemment le professeur Richard Lindzen a donné une conférence dans le cadre de l’association Clintel, et à l’aide de quelques figures reproduites ici il a (dé)montré le non sens de la notion d’une ‘température moyenne globale’. Les figures ci-dessous (Figs. 1 et 2) donnent l’enregistrement de la température pour environ 3000 stations sur un minimum de 100 années par station. La dispersion des valeurs de la température étant importante, les moyennes annuelles (Fig. 1) ou saisonnières (Fig. 2 ) sont calculées sur 30 ans pour chaque station, et la moyenne des écarts par rapport à la moyenne est finalement tracée. Dans les deux figures mentionnées ci-dessus, les données des stations sont représentées en noir et couvrent une période de 120 ans, les moyennes globales annuelles sont tracées en jaune (Fig. 1) et saisonnières en orange (Fig. 2). L’écart des anomalies est beaucoup plus important que l’écart plutôt faible des changements observés dans la moyenne dans chacun des deux cas. Bien que la moyenne (dans les deux cas ) montre une tendance, la plupart du temps, il y a presque autant de stations qui se refroidissent que de stations qui se réchauffent, du moins jusqu’en 2000.

La Figure 1 donne l’enregistrement de la température annuelle d’environ 3000 stations sur un minimum de 100 années par station. L’écart maximum des températures à l’échelle annuelle est de l’ordre de 11°C (de -6°C à +5°C) ou plus communément de 6 à 7°C (d’environ -3,5 à presque +4°C). On peut cependant y déceler un très léger réchauffement (presque 1°C/120 ans, soit 0,008°/an, en bon accord avec les données UAH rapportées par Roy Spencer).

La Figure 2 donne l’enregistrement de la température saisonnière d’environ 3000 stations sur un minimum de 100 années par station. L’écart maximum des températures à l’échelle saisonnière est de l’ordre de 20 à 21°C (de -12°C à +8,5°C) ou plus communément de 15 à 16° C (d’environ -8 à presque +8°C). On peut cependant y déceler un très léger réchauffement (très légèrement inférieur à celui de la figure 1, soit légèrement <1°C/120 ans, ou < 0,008°/an).

Les Figures 1 et 2 montrent que la température moyenne au cours du temps a peu varié par rapport aux variations. Les courbes jaunes et oranges représentent l’état du climat au cours de chaque année. Nous verrons plus loin (Fig. 4) que les fluctuations à l’échelle d’une journée, d’une semaine ou d’une période plus longue s’écartent très fortement de la ‘moyenne annuelle globale’.

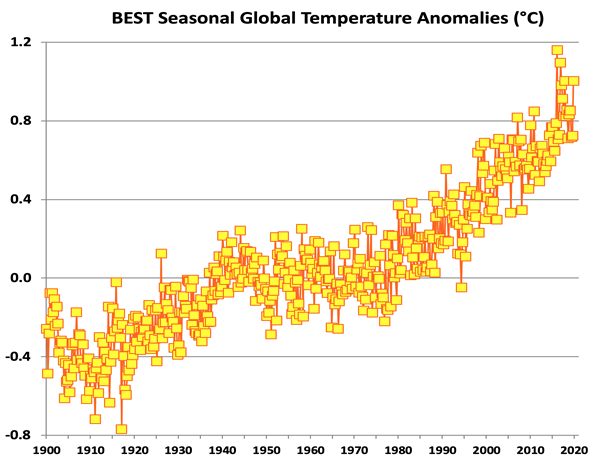

Hélas, ce ne sont pas ces figures qui sont présentées dans les médias et dans les cercles scientifiques, mais c’est par exemple la Figure 3. Ce genre de figure change complètement la donne car l’échelle de l’axe des Y (températures) est alors amplifiée d’un ordre de grandeur, à savoir un facteur 10. L’échelle des températures moyennes globales s’étend ainsi (Fig. 3) de -0,8°C à +1,2°C, avec des fluctuations de 0,1 à 0,2°C. L’amplitude totale (ici 2°C), de même que les fluctuations n’ont rien de ‘commun’ avec les écarts mis en évidence aux Figures 1 et 2, soit 11°C et 16°C respectivement. La courbe de la Figure 3 est beaucoup plus spectaculaire, alors que celles des Figures 1 et 2 représentent la situation réelle de notre ressenti quotidien, et se rapportent à des populations entières vivant au même moment avec des écarts ‘saisonniers’ de 16°C. Notons également que l’écart maximum de 2°C présenté à la Figure 3 est légèrement exagéré (mais c’est celui repris par Lindzen qui ne donne aucune référence), car le réchauffement que cet écart illustre est plutôt de 0,8°C en 150 ans (ici ou ici).

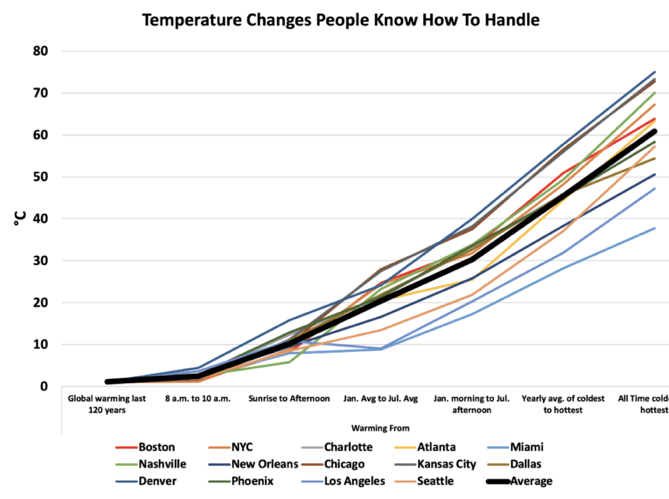

La dernière figure (Fig. 4) se veut une bonne confirmation de ce que les Figures 1 et 2 ont montré. Elle donne pour 14 villes américaines les fluctuations de température au cours de différentes échelles temporelles (horaire, lever du soleil jusqu’à l’après-midi, moyennes de janvier à moyennes d’août, matinées de janvier jusqu’aux après-midi de juillet, moyennes annelles les plus froides vis-à-vis des plus chaudes, des maxima les plus froids vis-à-vis des plus chauds). Ces écarts sont à comparer avec l’épaisseur du trait noir qui donne la variation totale de la ‘moyenne globale’ au cours des 120 dernières années. On voit immédiatement que cette ‘moyenne globale’ et sa variation (cf. également Figs. 1 et 2) sont insignifiantes par rapport aux autres fluctuations rapportées dans les 14 villes.

En conclusion, cette démonstration assez simple, faisant fi d’un éventuel rôle du CO2, est celle du bon sens tout court et de l’art de la présentation des données : pourquoi élargir l’échelle des températures d’un facteur 10 et placer ‘le débat’ en dixièmes de degrés, alors que nous vivons en permanence dans une fourchette de variations de température d’un autre ordre de grandeur. Le bon sens de tout un chacun doit ou devrait nous inciter à réfléchir et se demander comment quelques dixièmes de degrés peuvent engendrer une telle peur dans nos populations. Apprenons à réfléchir en terme local basé sur les observations et non sur base de modèles fondés sur des hypothèses, invérifiables. Nombre de situations actuelles n’ont elles pas déjà été rencontrées et bien documentées à l’échelle historique, voire au-delà?

Rappelons que SCE n’a jamais nié un réchauffement actuel, mais non seulement il est minime mais il ne date pas d’aujourd’hui, ayant débuté au sortir de Petit Age Glaciaire (ici).

ADDENDUM

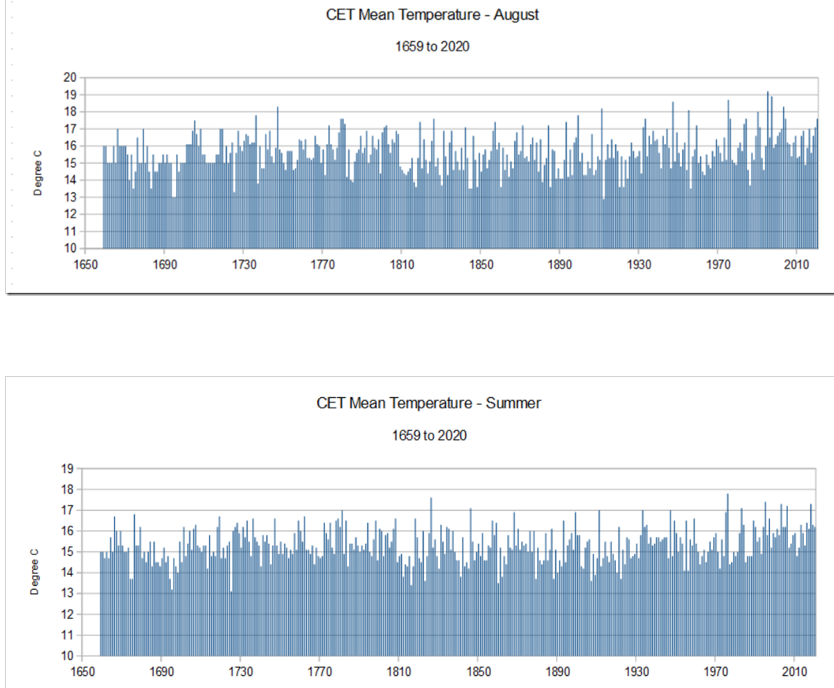

L’enregistrement historique le plus continu (= sur la plus longue période) de moyennes de températures est celui de l’Angleterre, (cf. figures ci-dessous concernant le mois d’août et l’été, voir ici également le MET Office) qui couvre la période 1660 à aujourd’hui.

A titre d’exercice placez-vous même une droite horizontale épaisse de quelques dixièmes de degrés à l’échelle de la figure ci-dessus pour vous convaincre que selon cette méthode objective, dans une échelle de température qui fait sens pour les différents milieux occupés par l’espèce humaine, rien de dramatique n’est à craindre (ici).

… et ceci ne concerne qu’un pays ou un région à l’échelle de la planète …., autrement dit les écarts par rapport aux différentes moyennes temporelles seront en encore plus grands si l’on considère les différentes zones terrestres (et océaniques), rendant encore plus insignifiant l’importance du réchauffement de quelques dixièmes de degrés, voire de 1 degré, sans compter qu’à l’échelle géologique (Pléistocène) de nombreuses périodes de réchauffement extrême avec des hausses de plus de 8°C en 40-50 ans se sont déjà produites (ici).

Excellent article

Je suis ingénieur civil ULg ’68 et lecteur régulier de Science-climat-energie et Association des climato-réalistes

Pour la figure 3, on voit bien que l’echelle verticale est dilatee.

En revanche, comment la figure 3 est elle construite ?

Comment passe-t-on d’une figure 2 a une figure 3, quelle moyenne est utilisee et avec quel poids pour chaque parametre ?

Comment sont-ils arrives a manipuler les donnees dans le but de faire peur ?

@ F. Toussaint

Vous soulevez une bonne question sur un sujet qui semble ne pas poser de problème a priori, en effet, intuitivement une température moyenne (ou globale) est une notion simple à comprendre, tellement simple qu’on ne va pas ’chercher’ plus loin… Pourtant il y a bien à re-dire !

La température moyenne est une sorte d’indice pour une vision globale. Elle fait l’objet de nombreuses critiques dans la littérature qui estime qu’une température moyenne globale n’a aucune signification physique.

La définition retenue est assez simple : c’est une somme pondérée des anomalies de températures locales, la pondération étant proportionnelle à la « surface de contrôle » (le lieu des points plus proche de la station météo considérée que de toute autre station; il faut penser en termes de « cercle d’influence » centré sur chaque station météo et à une pondération proportionnelle à cette surface). Comme le nombre de stations a changé dramatiquement en fonction du temps (chute de l’URSS, instabilités politiques au Moyen-Orient et indépendance de l’Afrique notamment), cela pose un problème de « raccord » de données au moment de ces « fermetures de station », puisque les surfaces de contrôle changent au profit des stations qui subsistent et qui se partagent « le gâteau » (= comprendre la zone d’influence) libéré par la station qui a disparu. Ce point a été abordé dans SCE (liens web au début de cet article).

Il faudrait donc un nombre très important de zones contiguës de surfaces égales, chacune possédant depuis le maximum de temps d’une station météo. Rappelons que la surface terrestre est couverte par un peu plus de 70% par les océans, et que le nombre de stations n’a jamais été suffisant pour remplir les conditions pré-requises. De plus, comme rappelé ci-dessus, elles ont été drastiquement réduites avec l’effondrement de l’URSS (globalement ‘plus froid’) de sorte que les stations du ‘monde occidental (globalement ‘plus chaud’) sont aujourd’hui sur-représentées. Autrement dit, c’est avec des stations en nombre et distribution variables que les principaux organismes météorologiques calculent pour chaque année la température moyenne globale. Ils le font certains en moyennant les deux hémisphères en attribuant une pondération d’environ 2/3 à l’hémisphère sud qui contient (très) peu de stations, d’autres en moyennant à part la zone intertropicale et les hémisphères suivant des pondérations différentes etc. On ne peut alors qu’être étonné au bout de compte de connaître l’évolution de la température moyenne à quelques dixièmes de degrés près, qui plus est sur 150 ans. A cela s’ajoutent les ilôts de chaleur urbains (cf articles dans SCE et nombreux articles dans la littérature) et des raccords entre périodes (voir ci-dessous) qui ‘ré-évaluent’ ou recalibrent des températures passées ? Ainsi, dans le rapport 1999 du GIEC, 1934 était l’année la plus chaude dépassant de 0,6°C l’année 1998. Dans le rapport 2011, la température pour 1934 est légèrement inférieure à celle de 1998. Parfois même un pays entier (Bolivie) se réchauffe alors que le nombre de stations de mesure pour ce pays est tombé à zéro après 1990 (in H. Areki :Climat, Mensonges et Propagande, 2010, Th. Souccar Ed). Il est à noter que les nombreux cas de recalibrage ou d’homogénéisation de température vont toujours dans le même sens ! Enfin notons également que les stations météos doivent respecter des règles précises : en 2010 seulement 10% des 1067 stations US étaient conformes aux normes officielles de qualité US (CRN1 ou CRN 2, voir le graphique dans le lien en fin de commentaire).

Reste à se pencher sur les anomalies locales de température. L’idée de la WMO (Organisation Météorologique Mondiale) est que pour distinguer le climat de la météo, il faut considérer l’évolution des températures sur une fenêtre temporelle de 30 ans. Ce concept est discutable car il induit des biais et fausses tendances quand il y a dans les données des composantes cycliques de période comparable ou supérieure à la durée de la fenêtre de référence, comme c’est le cas avec les températures locales,

voir https://www.science-climat-energie.be/2019/07/24/climate-about-which-temperature-are-we-talking-about/).

Les Centres météorologiques, en suivant la WMO, prennent donc la température locale moyenne sur une période de 30 ans puis, pendant les 30 années suivantes, ils considèrent les écarts de température par rapport à cette ligne de base (qui change tous les 30 ans, et c’est là un des paradoxes de leur approche, puisqu’ils supposent que « normalement » la température devrait rester constante.) C’est néanmoins la définition de l’anomalie de température locale qui permet donc de comparer ce qui se passe en divers points du globe et de passer de la Figure 1 à la Figure 3.

Outre le choix de la longueur de cette fenêtre de calibrage de 30 ans, le choix de l’instant initial de cette période de référence de 30 ans n’est pas anodin et provoque lui aussi des fausses tendances et des biais (surtout, tout comme pour la longueur de la fenêtre de référence, s’il y a dans les données des composantes cycliques de période comparable ou supérieure à la longueur de la « fenêtre de calibrage ») comme mentionné ci-dessous (lien web SCE ci-dessus).

La première période de référence s’étendait de 1930 à 1960 ; puis de 1960 à 1990 ; et depuis le début de l’année, la période de référence 1990-2020 fait l’objet des nouveaux travaux. Les passages d’une période à l’autre nécessitent quelques « arrangements des données » pour assurer la continuité des anomalies.

Pour faire simple, la NASA prend d’autres périodes de référence. La première commence avec le lancement des premiers satellites météo (vers 1970) et dure également 30 ans. Ceci pourrait expliquer (partiellement) les écarts observés entre les anomalies mesurées à partir de satellites (cf. Roy Spencer) et à partir de stations terrestres (qui sont, de plus, affectées par l’effet de « îlot urbain »), voir ici

https://www.science-climat-energie.be/2021/03/12/chaleur-urbaine-et-temperature-globale/?fbclid=IwAR2AfUyF4giteJkFmBhuBIN-U1XI3uuVJyimb72CNcQzmUpc44Il3HiWcjI).

Finalement à votre question ‘Comment en sont-ils arrivés là pour faire peur’, la réponse est surtout dans l’absence d’esprit critique de tout un chacun. S’il y a intentionnalité de faire peur, ce que beaucoup de concitoyens pensent et ce que souvent ‘les Unes’ de la presse affichent, la responsabilité de ceux qui propagent la peur est grande, mais ici on entre dans une autre thématique… bien souvent loin de la science.

Pour aller plus loin avec ce problème de température moyenne (y compris les erreurs de mesure), voir ci-dessous un document très complet qui a été présenté lors d’une conférence :

https://www.dropbox.com/scl/fi/4t2f2pm8rgvp21kro17o1/Climate-data-analytics.pptx?dl=0&rlkey=ccda6t099169md7f4whx8mmd4

j’ai largement commenté dans mes livres et vidéos la stupidité d’assimiler des moyennes de température à des températures moyennes et je vais reprendre le thème dans un MOOC de la climato-science en cours d’élaboration. 0Un des arguents que je développe pour convaincre les gens que c’est une ineptie est de considérer une situation dans laquelle toutes les stations enregistreraient en même temps la même température par exemple 20 degrés ce qui conduirait à considérer que la température moyenne de la Terre serait de 20°. Le lendemain une masse d’air chaud se déplace d’une zone à une autre. La température e la première zone descendrait et la tempéraure de la seconde augmenteraitmais il n’y a pas la moindre raison que la baisse de température de l’une soit égale à la hausse de l’autre de sorte que la moyenne serait modifiée sans qu’il y ait aucun apport de chaleur !

Il n’y a qu’un’ seule définiton correcte de la température moyenne de la terre c’est de la définir comme la température du corps noir émettant la même énergie

Merci pour ce rappel! Effectivement la ‘température globale moyenne’ n’a pas de sens physique et de nombreux biais sont à prendre en considération. Ce sujet a été abordé plusieurs fois par SCE, notamment ici : https://www.science-climat-energie.be/2019/07/24/climate-about-which-temperature-are-we-talking-about/

Bonjour,

Le but est-il de faire peur ?

Quels seraient les buts réels de ces manipulations statistiques ?

Te faire accepter des mesures débiles, comme dépenser des milliards pour faire baisser de 4,8% la participation française de 0,9% au RCA d’un gaz qui est à 0,04% dans l’atmosphère, argent qui aurait été bien mieux ailleurs (retraites, santé,…). En parallèle, combien d’augmentation pour la Chine? L’Inde?

La fin du capitalisme (le capitalisme c’est mal)

Le retour au communisme (parce que ça, c’est bien)

L’appauvrissement de la population (« Vous ne posséderez rien et vous serez heureux » )

C’est la même technique que pour te faire essayer de te faire vacciner, te faire peur. Il y a toujours un but quelque part.