Prof. (emer.) Dr. Ir. Henri Masson

Universiteit Antwerpen

Le présent article est très largement et librement inspiré de « Chaos: The amazing science of the unpredictable« , par James Gleick (Vintage 1998).

1. Un nouveau paradigme : les systèmes chaotiques

« Depuis les premiers balbutiements de la Physique, le désordre apparent qui règne dans l’atmosphère, dans la mer turbulente, dans les fluctuations de populations biologiques, les oscillations du cœur et du cerveau ont été longtemps ignorées ».

« Il a fallu attendre le début des années soixante-dix, pour que quelques scientifiques américains commencent à déchiffrer le désordre, il s’agissait surtout de mathématiciens, médecins, biologistes, physiciens, chimistes cherchant tous des connections entre diverses irrégularités observées. Le syndrome de la mort subite fut expliqué, les proliférations puis disparitions d’insectes furent comprises et modélisées, et de nouvelles méthodes d’analyse de cours boursiers virent le jour, après que les traders aient dû se rendre à l’évidence que les méthodes statistiques conventionnelles n’étaient pas adaptées. Ces découvertes furent ensuite transposées à l’étude du monde naturel : la forme des nuages, les trajectoires de la foudre, la constitution de galaxies. La science du chaos (« dynamical systems » pour les anglo-saxons) était née et allait connaître un développement considérable au fil des années ».

« Cette nouvelle science s’appuie sur des techniques mathématiques et graphiques innovantes aptes à révéler la structure infiniment sophistiquée qui sous-tend la complexité d’un désordre qui n’est qu’apparent … Elle permet d’analyser et de décrire l’évolution des volutes de fumée s’échappant d’une cigarette ou l’homogénéisation progressive d’un nuage de lait dans une tasse de thé (ou de café) ; ou encore la congestion du trafic automobile, voire l’écoulement de pétrole dans un pipeline. On retrouve une signature chaotique partout. Il s’agit d’une science qui s’adresse au comportement global de systèmes » ; elle est pluridisciplinaire par essence, à contre-courant de la recherche d’expertise à outrance conduisant à former des scientifiques « pointus » qui, en fin de compte, «savent tout sur rien», ne voyant plus que l’arbre qui cache la forêt.

« Les premiers chercheurs à s’intéresser au chaos avaient un œil apte à déceler des formes, des structures qui se répètent du niveau microscopique au macroscopique. Ils manifestaient une attention particulière pour les irrégularités et soubresauts qui venaient enrichir un phénomène apparemment déterministe, ou au contraire parfaitement aléatoire. Ils tournèrent le dos au déterminisme et à la recherche de constituants élémentaires (quarks, bosons en physique, chromosomes et neurones en physiologie, etc.) de la science du 20ème siècle ». Ces chercheurs sont les précurseurs de la pensée systémique.

« A côté de la théorie de la relativité, de la théorie quantique, le chaos est sans doute la troisième révolution qui aura marqué la physique du 20ème siècle. Ces trois disciplines mettent radicalement en cause le « déterminisme newtonien » de la mécanique classique (« tout est mesurable et contrôlable ») et le rêve Laplacien de « prédictibilité déterministe ».

« Contrairement aux deux autres disciplines mentionnées, le chaos s’adresse au monde « tangible ». Quelques physiciens sortant de leurs abstractions propres à la physique théorique redécouvrirent que s’il leur était possible de décrire le comportement d’une goutte d’eau par des équations déterministes (les équations de Navier-Stokes), il leur était impossible de décrire, et encore moins de prédire, l’écoulement d’une rivière en crue ou le cheminement des filets fluides tombant d’une cascade ». Comment prédire quelle sera la distance séparant deux « particules » d’eau, voisines au départ, un instant plus tard, dans un tel environnement ?

2. Un pionnier

« Le développement moderne de la théorie du chaos commença avec une découverte qui eut un effet d’électrochoc : une infime différence des conditions initiales peut engendrer des différences énormes dans un système non linéaire. C’est le célèbre « effet papillon » ; exprimé sous une forme imagée, celui-ci s’énonce comme suit : « un léger battement d’ailes d’un papillon en Amazonie peut engendrer une tornade aux États-Unis ».

Voici l’histoire de cette découverte.

« Nous sommes au début des années soixante et dans son laboratoire du MIT, Edward Lorenz (Fig.1), un matheux que les hasards et besoins de la deuxième guerre mondiale ont transformé en météorologue, fait tourner un système de quatre équations sur son ordinateur oh combien rudimentaire » : un assemblage de tubes et diodes placé dans un cabinet ressemblant à un frigo américain et sur le toit duquel on pouvait cuire un œuf, à cause des pertes de chaleur qu’il engendrait.

Pendant que sa machine tourne, il rêvasse en regardant par la fenêtre les circonvolutions des nuages qui passent dans le ciel. Un sujet qui le passionne depuis longtemps.

Ses quatre équations constituent un modèle hyper-simplifié de l’atmosphère, essayant de combiner les lois physiques de la gravité, de la viscosité de l’air et de la convection naturellement induite par une source de chaleur externe représentant le soleil.

« Contrairement aux météorologues de son temps, Lorentz ne s’intéressait pas aux relevés de température, pression, humidité, ni à l’identification de leurs maxima et minima au fil des saisons et des années, une discipline bien établie relevant des statistiques descriptives, mais il s’intéressait plus particulièrement à la façon dont ces données pouvaient changer brutalement, et plus précisément encore à l’estimation de leur prédictibilité à plus ou moins long terme. »

Sa machine rudimentaire imprimait initialement, très péniblement, ligne après ligne, sur une imprimante ‘préhistorique’, des lignes de chiffres.

« Lorenz était le Dieu de cet univers virtuel, choisissant à sa guise les lois qu’il voulait appliquer. Par essais et erreurs successifs, il en sélectionna 12, qui décrivaient les liens entre température et pression et entre pression et vent. Lorenz pensait que ses formules combinant quelques lois de la mécanique, de la physique et de la thermodynamique, faisaient de lui le grand horloger d’une machine qui devait tourner pour l’éternité. Il était convaincu à l’époque, comme tous ses pairs, que « Comprendre les Lois c’est comprendre l’Univers. »

C’était encore l’époque où, en mathématique, on résolvait les équations analytiquement à la main, et pour y arriver, on faisait des changements de variable, et des approximations (de linéarisation), en laissant tomber les erreurs d’ordre supérieur, pensant que celles-ci étaient négligeables. Par changements de variables successifs, Lorenz obtint finalement ses 4 équations, et cela sans devoir introduire la moindre approximation.

« À cette époque, la météorologie n’était rien de plus qu’une sorte de devinette visant à prévoir le temps du lendemain, sur base des relevés fournis par les instruments de mesure équipant les stations météo. »

« Lorenz voulait, à partir des lois de la mécanique, de la physique et de la thermodynamique, y apporter plus de rigueur mathématique et de précision ». Ne doutant de rien, il voulait non seulement simuler une situation instantanée, mais en plus décrire son évolution en fonction du temps.

« À cette époque aussi, peu de scientifiques voyaient un quelconque intérêt à utiliser les ordinateurs, considérés comme rien de plus que des gadgets électroniques bien éloignés des préoccupations de la « science sérieuse ».

« Une amélioration notable dans le travail de Lorenz se produisit quand il transforma son imprimante en imprimante graphique. Pour cela, il imprima çà et là sur chaque ligne, de petits symboles entrecoupés de blancs, chaque symbole représentant un seuil de pression, de température, voire, la force ou la direction d’un vent ». La feuille entière devenant ainsi progressivement une carte météorologique rudimentaire.

« Rapidement au sein de ce laboratoire du MIT, on s’adonna à une nouvelle sorte de jeu de hasard. Les collègues de Lorenz et lui-même essayaient de deviner comment, en changeant les conditions initiales et les paramètres du modèle, les symboles allaient se déplacer, en fonction du temps », c’est-à-dire d’une page imprimée à la suivante.

3. La découverte aussi fortuite que fondamentale

« Un jour de l’hiver 1961, Lorenz voulait examiner une séquence plus longue que d’habitude. Au vu de la lenteur de sa machine, il décida de partir non pas de l’origine de ses calculs, mais d’un point proche de la fin de sa première simulation. Il entra les paramètres correspondant à cet état, lança sa machine et partit prendre un café, en attendant les résultats. »

Surprise à son retour ! Les résultats, absolument concordants au début entre sa courbe initiale et son prolongement se mirent rapidement à diverger. Croyant à une erreur de programmation ou à une défaillance de son ordinateur, Lorenz revérifia le tout, encore et encore.

« Inexplicable…. jusqu’au moment où il comprit finalement qu’il avait introduit manuellement des valeurs approchées à la troisième décimale des valeurs générées par sa simulation initiale, qui elles avaient été calculées et imprimées avec six décimales. Il venait de découvrir l’extrême sensibilité aux conditions initiales de certaines équations non linéaires. Il comprit rapidement aussi que des systèmes décrits par de telles équations sont pratiquement imprédictibles, vu les erreurs de mesure qui entachent immanquablement les valeurs des conditions initiales. Bien que les modèles de Lorenz ne représentaient qu’une caricature simpliste de la complexité de l’atmosphère, il venait de comprendre l’essence même de la météorologie et de la climatologie. Ces disciplines essayent en fin de compte de prédire le comportement d’un système extrêmement complexe, qui est en fait mathématiquement imprédictible à relativement long terme. »

J’en doute direz-vous ? Peut-être aussi évoquerez-vous les marées océaniques. « Le système est également complexe direz-vous et présente également des périodicités multiples ; et cependant on parvient à prévoir assez correctement l’amplitude des marées, longtemps à l’avance. C’est vrai, mais il s’agit là de la tendance générale du comportement du système océanique. Cependant, on est toujours incapable de prédire avec exactitude l’arrivée d’une tempête en un point donné, longtemps à l’avance. Pour le climat les choses sont différentes ; la tendance générale est supposée bien connue par tout le monde : à chaque hiver succèdera un été puis un autre hiver. C’est aux détails qu’il convient de s’attacher (les « anomalies ») et ceux-ci sont parfaitement imprédictibles. » (voir ici).

« Cette découverte

fondamentale faite par Lorenz resta longtemps obscure, sans doute parce que,

comme météorologue, il publia logiquement le résultat de ses travaux dans une

revue de météorologie. » Ses considérations mathématiques, pas

vraiment « digestibles » par ses collègues météorologues, ne furent

connues d’un public plus aguerri aux mathématiques que plusieurs années plus

tard. On peut parler d’un secret partagé pendant plus d’une décennie par

quelques scientifiques excentriques (des « mavericks » diraient les anglo-saxons).

4. Les hyper-ordinateurs à l’œuvre

« Progressivement cependant, certains météorologues commençaient à penser que les temps étaient mûrs pour appliquer la force brute des ordinateurs à la prévision météorologique, en répétant sans cesse les calculs fastidieux découlant de la juxtaposition des nombreuses lois physiques à prendre en compte simultanément. »

Les anomalies de température (et le calcul de résidus)

À un moment donné, la température en divers points du globe varie entre moins 60°C et plus 50°C. En un point donné, la température varie au fil des saisons de quelques dizaines de degrés et de quelques degrés entre le jour et la nuit. Les anomalies de température ont été utilisées pour comparer les « dérives » de température en fonction du temps d’un point à l’autre du globe. On parle en climatologie d’une dérive globale de quelques centièmes de degré par an.

On calcule l’anomalie de température en un point en comparant la température mensuelle moyenne à la moyenne de celle-ci calculée sur une période de référence qui s’étend sur les trente années précédentes (1930-1960, puis 1960-1990 ; la prochaine période de référence sera 1990-2020). La démarche est apparemment louable, car elle permet de comparer l’évolution de température en divers points du globe. Elle souffre cependant du fait, que la température en un point n’est pas constante sur le long terme. Les relevés ponctuels de température révèlent en effet des périodicités aussi multiples que significatives, s’étendant de façon quasi continue entre un jour et plusieurs millions d’années, en passant par des composantes décennales et centennales, qui rendent le concept même d’anomalie de température hautement discutable, pour ne pas dire inadapté.

Car d’un point de vue purement statistique, l’approche est paradoxale. Les anomalies de température ne sont rien d’autre statistiquement qu’un calcul de résidus, subsistant après l’application d’un modèle à des données expérimentales.

En inférence statistique, quand après un calcul de courbe de régression, les résidus ne sont pas constants et négligeables, on conclut que le modèle est imparfait et l’on change de modèle. Le GIEC lui interprète la non-constance des anomalies de température en clamant que c’est le système climatique qui dérive, tout en gardant une confiance aveugle dans ses modèles.

« Il faut se souvenir que les années soixante ont vu l’émergence de deux techniques révolutionnaires : le développement des ordinateurs et la conquête de l’espace. Sous l’impulsion de John von Neumann, attaché à IBM, tout un courant de pensée « mainstream » s’est développé, basé sur l’idée qu’en accumulant des masses considérables de données par observation satellitaire et en les faisant ‘digérer’ par un super ordinateur, on devrait finir par pouvoir décrire le système climatique. »

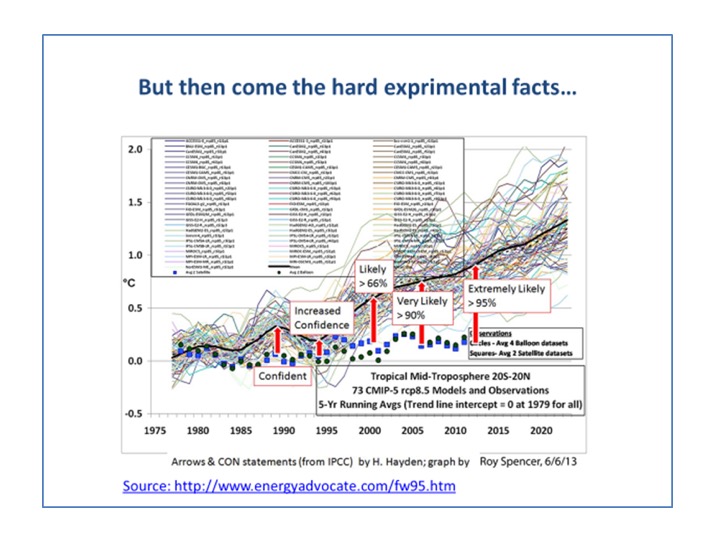

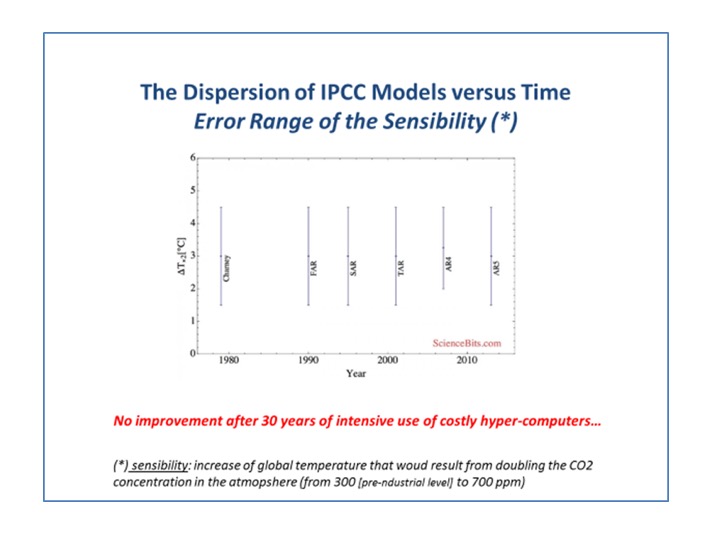

« C’est ainsi qu’au fil du temps, les douze équations de Lorenz en sont devenues 500 000. Mais 50 ans plus tard, les dizaines de modèles tournant pendant des jours voire des semaines sur de gigantesques ordinateurs ultra puissants et rapides ne sont toujours pas parvenus à simuler correctement l’évolution de la température moyenne du globe » (Fig. 2), et peut-être pire, les divergences entre simulations fournies par les divers modèles n’ont pas diminué depuis les premières tentatives de simulation digitale (Fig. 3).

« Il fallait se rendre à l’évidence la météorologie est extrêmement compliquée, et par ailleurs, le Principe d’Incertitude d’Heisenberg (voir ici) commençait à faire germer des doutes quant à l’optimisme de Laplace concernant le déterminisme de toutes choses dans la Nature. »

Il est tout simplement impossible de prédire la météo au-delà de quelques jours, essayer de moyenner celle-ci sur l’espace et le temps pour en faire un exercice de climatologie est un non-sens.

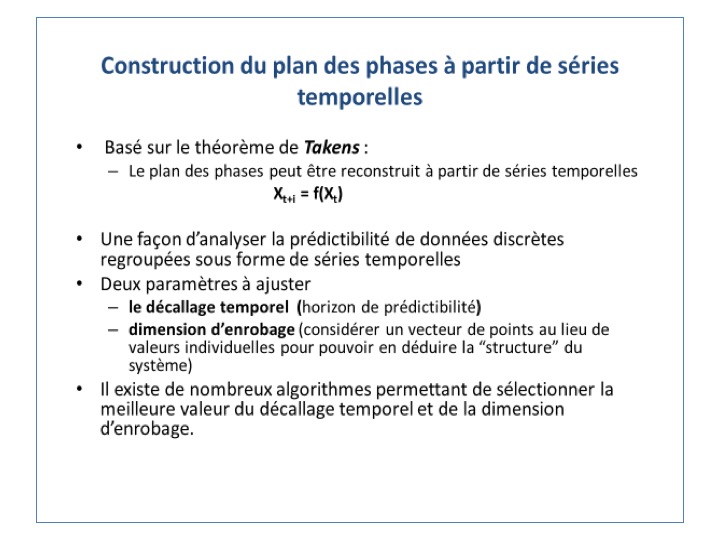

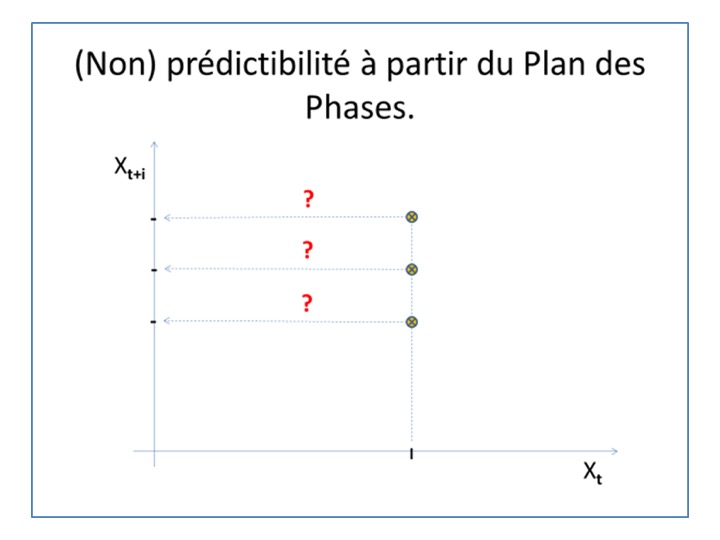

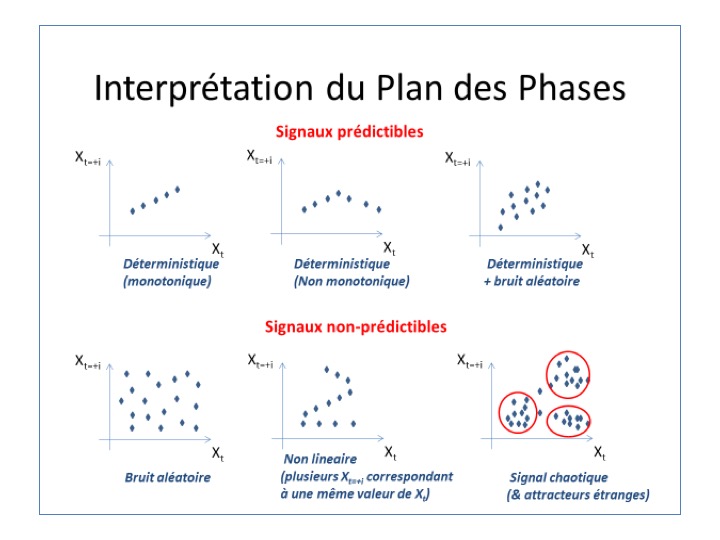

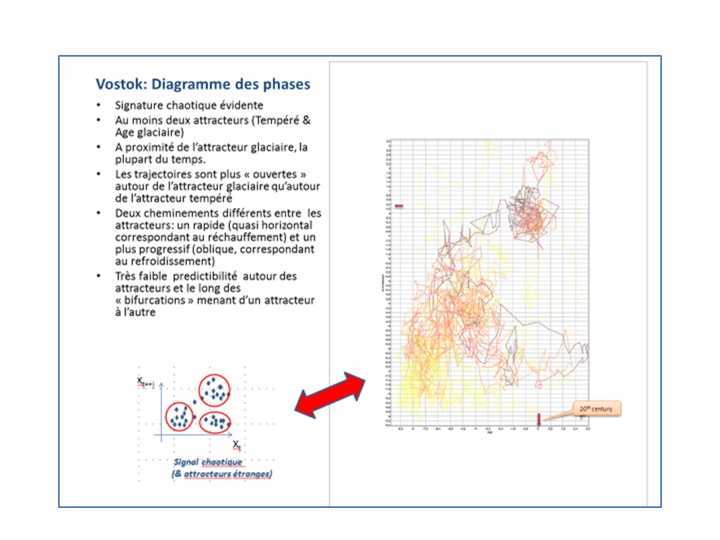

La faute en est à l’effet papillon (Fig. 4). En y regardant de plus près, avec des outils mathématiques développés spécialement pour étudier ce genre de systèmes, on s’aperçoit que les points ne sont pas distribués « normalement » (selon une distribution en cloche de Gauss) autour d’une moyenne ou d’une ligne de tendance, mais se répartissent autour de deux ou plusieurs « attracteurs étranges » autour desquels ils gravitent pendant un certain temps, avant de brutalement bifurquer d’un attracteur vers l’autre. Un tel système ne peut se décrire par une ligne de tendance purement déterministe et un certain bruit aléatoire qui s’y superpose. Entre ordre et désordre aléatoire existe un autre état, l’état chaotique, présentant des structures et des caractéristiques dynamiques propres qu’il convient d’aborder avec les outils mathématiques ad hoc, bien différents de ceux employés en statistique conventionnelle…et malheureusement non enseignés ni aux climatologues, ni aux informaticiens qu’ils emploient.

« Il est aussi illusoire de croire qu’on puisse modifier un tel système en modifiant volontairement l’un ou l’autre de ses paramètres. Cela revient à ajouter une carte à un château de cartes. On ne peut prédire ce qui va se passer : quand et comment le château de cartes va s’effondrer. Certes, on peut essayer de modifier un tel système, mais l’effet est absolument imprédictible ». C’est pourtant ce que prônent le GIEC et les gouvernements voulant imposer une politique minimisant l’empreinte carbone.

« Ce que Lorenz a découvert c’est le lien universel existant entre non-linéarité et non-prédicibilité »

5. La désillusion produite par les modèles mathématiques

La mécanique des fluides repose sur les équations de Navier-Stokes liant température, densité et viscosité. Ces équations sont non linéaires et ne peuvent être résolues analytiquement, sauf dans le cas de géométries très simples. Les algorithmes utilisés pour les résoudre numériquement (Runge-Kutta, etc.) présentent eux-mêmes un caractère chaotique quand on les applique à des systèmes non linéaires.

Il est parfaitement illusoire d’espérer simuler un système chaotique avec des algorithmes présentant eux-mêmes un caractère chaotique, alors que les conditions initiales et les conditions aux limites sont entachées d’erreurs expérimentales loin d’être négligeables (Figure 5).

sur la période 1963-2012. (source : American Meteorological Societ’s Journal of Climate, AMS 2016 ). Les 30 simulations ont été réalisées dans le cadre du projet CESM. Elles illustrent les effets anthropiques et naturels des fluctuations de température. La moyenne EM de ces modèles (2ème figure depuis la droite sur la ligne inférieure) élimine les contributions naturelles pour ne garder que la contribution anthropique. La figure OBS à l’extrême droite de la dernière ligne montre les tendances observées. Les 30 simulations correspondent rigoureusement aux mêmes conditions initiales et valeur des paramètres, à un détail près : d’une simulation à l’autre la température initiale a été modifiée de 1/ 1 000 000 000 000eme de degré C !!!

Cet exemple illustre parfaitement qu’il n’y a rien de neuf depuis E. Lorenz. En utilisant des méga-ordinateurs alimentés par des milliers d’équations, au lieu d’un ordinateur rudimentaire tournant sur des équations simplifiées comme le fit Lorenz, on arrive au même non-sens : répéter les simulations et en prendre la moyenne conduit à une impasse. La moyenne des simulations n’est pas en accord avec les mesures observées, et pire, on fait dire aux modèles du GIEC exactement ce que l’on veut, en modifiant un des paramètres de façon infinitésimale. On peut espérer naïvement que les modèles mathématiques (et leurs algorithmes calculant une moyenne) permettent de « gommer » la signature chaotique affectant un phénomène complexe, mais en réalité, les modèles eux-mêmes, par la structure des équations utilisées, donnent un caractère chaotique aux résultats qu’ils produisent.

6. Le climat présente une signature chaotique

On peut très aisément le prouver mathématiquement à partir des relevés de température (Figs. 6a à 6e), mais on peut aussi le comprendre intuitivement en énonçant simplement les caractéristiques des phénomènes qui l’affectent.

Linéarité, périodicité, chaos et prédictibilité

Un système linéaire donne une réponse qui est soit stable, soit continuellement croissante soit encore continuellement décroissante. Un système linéaire est parfaitement prédictible.

Un système oscillant est par essence non linéaire. Ces oscillations peuvent être parfaitement mono-périodiques. Un tel système reste lui aussi parfaitement prédictible et se répète à l’infini.

Un système pluri-périodique présente un comportement plus complexe mais reste relativement prédictible, pour autant que l’on connaisse exactement l’amplitude, la période et la phase initiale de chaque sinusoïde qui décrit son comportement.

Un système peut devenir chaotique soit lorsque les périodicités différentes se multiplient à l’infini, soit lorsque sa réponse influence son excitation entrante (rétroaction ou « feedback » en anglo-saxon) et qu’il y a compétition entre une rétroaction non instantanée positive (amplifiante, source de réponses de plus en plus grandes) et une autre négative (visant à faire diminuer la réponse jusqu’à la faire disparaître). Un tel système est non périodique (« apériodique »).

Une vue hétérodoxe du système climatique

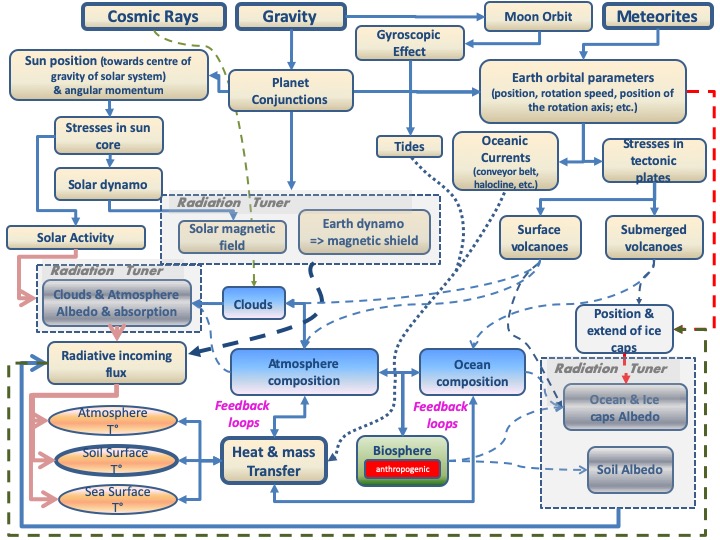

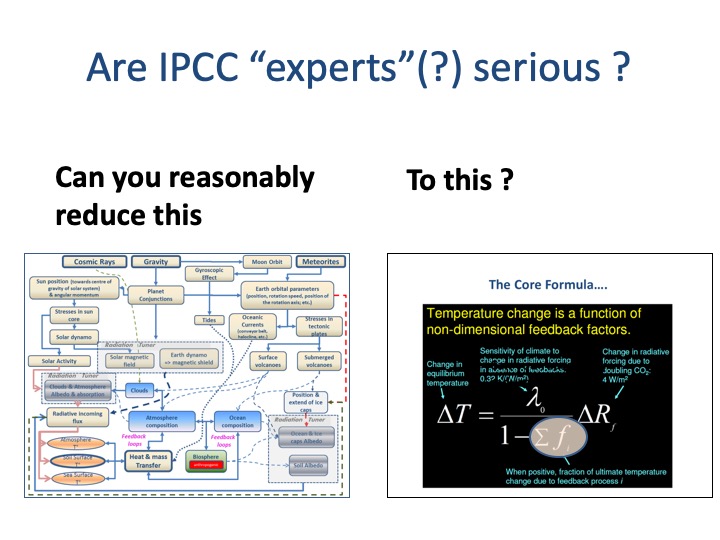

Le système climatique terrestre est lié à une source (le Soleil) dont l’intensité présente une signature chaotique. Cette source s’applique à la Terre dont l’inclinaison, et donc l’exposition au Soleil, varie de façon chaotique. L’intensité du rayonnement solaire incident est aussi modulée par les nuages jouant le rôle de thermostat. La couverture nuageuse dépend quant à elle de la présence de rayons cosmiques dans l’atmosphère, selon les dernières recherches en la matière (voir ici). L’abondance de ces rayons est elle-même modulée par les champs magnétiques terrestre et solaire, qui constituent en fin de compte le véritable organe de régulation du système, et dont les intensités présentent également une signature chaotique. Et on voudrait que la résultante (le changement de l’anomalie de température moyenne globale) des divers phénomènes cités soit déterministe et donc prédictible ? Toutes les fluctuations évoquées ci-dessus seraient-elles trop faibles que pour affecter significativement le signal de sortie (l’anomalie de température moyenne) comme le prétend le GIEC ? Que de non ! Car, précisément, à la suite de l’ensemble des interactions mentionnées ci-dessus, le système climatique terrestre est hautement non linéaire et chaotique et donc hypersensible aux conditions initiales et à la valeur des trop nombreux paramètres qui le pilotent (Figs. 7a et 7b).

7. Conséquences

Croyez-vous encore que la température moyenne globale serait déterministe et donc prédictible, voire contrôlable en réduisant l’empreinte carbone anthropique (du monde occidental, les autres nations adoptant une position plus attentiste)? Le GIEC et quelques hommes politiques influents (Obama, Al Gore, Hollande, Macron, etc.) en sont toujours persuadés et vous font les poches, sous forme de taxes carbone, d’augmentation de votre facture d’électricité, j’en passe et des meilleures, pour pousser plus loin leur utopie… à vos dépens.

8. Références

Chaos: The amazing science of the unpredictable, James Gleick (Vintage 1998).

9. On the same subject

Does the Climate System Have a Preferred Average State? Chaos and the Forcing-Feedback Paradigm. October 25th, 2019 by Roy W. Spencer, Ph. D.

Y a toujours moyen de moyenner. 25 novembre 2019 bu MD, Mythes Mancies Mathématiques

Bonjour,

Merci pour cette édition.

Un texte d’une grande intelligence. Il demande un effort intellectuel que les ignorants refusent toujours de faire. Ce n’est pas contre les fantasmagoriques changements climatiques qu’il faut lutter, c’est contre l’ignorance et la paresse intellectuelle!

Merci pour votre commentaire.

Je vous rejoins totalement en ce qui concerne la lutte contre la paresse intellectuelle. j’ajouterais qu’il conviendrait de développer l’exercice de la pensée critique et systémique en groupe, en employant des cartes cognitives pour analyser les problèmes, et cela dès le plus jeune âge.

En Belgique et en France on est malheureusement très loin du compte .

Merci Prof. Masson de votre bien utile rappel.

Votre fig.7a. relative au “méta-modèle climatique” invite à réfléchir la complexité intrinsèque de tous les |building blogs| climatiques. Avant qu’y soit appliqué (en leur globalité) un regard holiste [1]. Or les diverses approches préconisées par les thuriféraire du GIEC ne peuvent (ou ne veulent ?) respecter cette logique.

En un court biais vers les systèmes dynamiques non-linéaires et la théorie du chaos : ceci rappellera les travaux d’Henri Poincaré et ceux suivants. On notera l’acception exacte de l’expression « La théorie du chaos » qui ne dit pas: petites causes, grands effets mais bien: « de petites variations dans les données de départ entraînent des comportements imprédictibles » ! [2]

On se réjouira aussi utilement de l’ouvrage de David Ruelle. [3]

« L’affaire climatique » ambiante me fait penser à ce qu’invoque Mme la Prof. Janine Guespin-Michel (professeur émérite de microbiologie à l’université de Rouen) à propos de « L’affaire Lyssenko » vécue dans l’ex-URSS stalinienne et les catastrophes qui en résultèrent pour la population à cause d’une trompeuse « théorie génétique agricole russe » du 20e siècle !

Voir ainsi explicitement dans l’essai 2016 de l’auteure :

= = LA RÉVOLUTION DU COMPLEXE = =

Sciences, dialectique et rationalité (117 p., à lire en ses p.9 à 11)

http://www.revolutionducomplexe.fr/images/downloads/revolutionducomplexeguespin.pdf

Dans notre 21e inféodé au politiquement correct, « L’affaire climatique » entremêle du simplisme et du contradictoire. Pour ne citer qu’eux, des milieux d’activistes verts préconisent une approche holiste [1] de notre avenir terrestre. Bien mais ils la décomposent vite en une cohue de thèses et d’actions très fragmentées, chacune d’elles étant exprimée à dessein par des vue réductrices et une argumentation fataliste. D’où au final une somme de spéculations parfois/souvent douteuses. Spéculations dont ces mêmes acteurs ne peuvent évidemment démontrer l’effet global par l’observation mais plutôt grâce à des projections « modèles à long terme ». Ça impliquerait-il l’inexistence d’aléas (?) dans la science du climat, sinon une extrême difficulté à vouloir les modéliser… s’ils étaient vraiment identifiés ?? p.ex. [3] [4]

Au-delà, le milieu médiatique se charge vite d’amplifier le « discours projectif (en une version simplifiée), à destination des décideurs politiques et de nos foules », ces êtres et les autres restant largement aveugles face aux présupposés mais néanmoins armés de puissants leviers d’orientation grâce aux effets répandus par bruits et rumeurs (les fake news). De là à rapprocher les comportements d’acteurs présents de ceux de la « croyance » ? Sous cette forme-là, feu André Malraux ne l’avait guère anticipée !

L’essai préalablement cité de Mme Guespin-Michel s’étend (en son Chap. II, p. 36) sur les travaux d’Edgard Morin qui développa en 1982 sa thèse de « pensée complexe ». Je ne sais toutefois si de nombreux penseurs du climat l’auraient lu en profondeur…

L’essai en son Chap. IV.3. porte sur un raisonnement « biologie » :

= Pressions économiques sur les paradigmes scientifiques: l’exemple de la biologie. =

L’auteure touche aussi à : IV.3.2. = Intervention de la commission européenne dans le soutien au réductionnisme = (au travers de ses « Framework Programmes »… d’output inévitablement relayés par les politiciens des Etats membres U.E.) ! La boucle se boucle t-elle ici avec rigeur ?

L’auteure ne fait pas l’impasse sur un possible glissement idéologique (Chap. V, p. 83), ni sur « L’obstacle de la pensée dominante » (p. 90).

Pour conclure son essai avec : « Vers un renouveau du rationalisme » (p.95) , en y frôlant d’inévitables positions politiques ?

TRANSPOSONS ? Peut-être s’agirait-il d’appliquer le sens des raisonnements ci-avant aux thèmes climatiques qui tant accaparent et perturbent les pensées de nos concitoyens, en plus de certains chercheurs ! Sans devoir aborder ici des facettes financières masquées, bien réelles à y associer. Car tout cela impactera l’avenir du monde…

[1] https://www.cnrtl.fr/definition/holisme

[2] repris de http://villemin.gerard.free.fr/Wwwgvmm/Chaos/Chaos.htm

[3] http://documents.irevues.inist.fr/bitstream/handle/2042/53361/METEO_1993_3_75.pdf

[4] Cours: http://www.cmap.polytechnique.fr/~bodineau/MAP432-Poly.pdf

Le Pr H Masson fait donc partie des 10% de scientifiques climatosceptiques.

90% des scientifiques de la planète reconnaissent le forçage anthropique dont le principal facteur est le CO2.

Ce qui fait débat ce sont l’ampleur et les conséquences du forçage.

Sans faire de savants calculs, en portant sur la même échelle de temps, de l’an 1000 à nos jours, la teneur en CO2 de l’atmosphère, le PIB mondial en milliards de $ et la consommation d’énergie en TWh on observe depuis le début de l’ère industrielle (+/- 1850), en moins de 200 ans, une croissance exponentielle de ces trois facteurs

Cette corrélation est sans discussion et le caractère anthropique du CO2 est difficilement contestable vu que les énergies fossiles sont les principales sources d’énergie depuis la fin du XIXième siècle. Si on en doute, le détour par l’analyse des isotopes du C devrait achever de convaincre un scientifique objectif.

Le CO2 est le gaz anthropique à effet de serre le plus important et sa durée de vie dans l’atmosphère est de plus de 1000 ans (encore 40% après 100 ans). Donc sans diminution des émissions son effet radiatif continue à augmenter. La vapeur d’eau a un effet radiatif plus important par unité de masse mais sa durée de vie dans l’atmosphère n’est que de 7 à 10 jours et la quantité de vapeur d’eau liée à l’activité humaine est négligeable comparée à celle due à l’évaporation à la surface des océans.

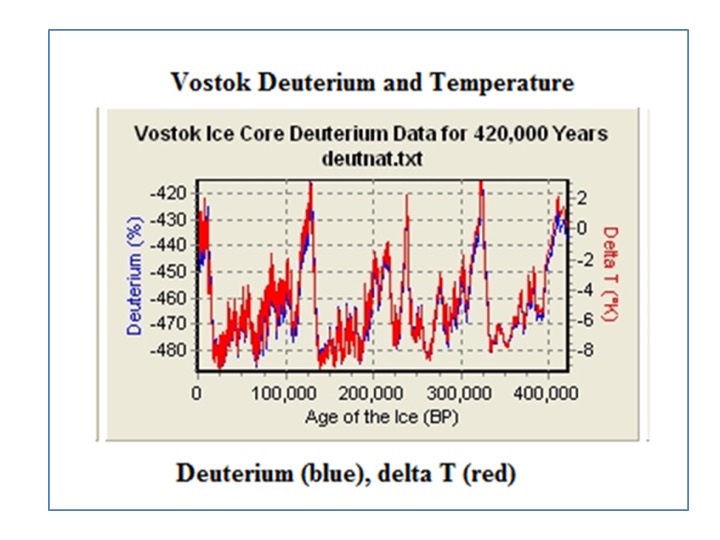

Les cycles de variations de deutérium mentionnés par le Pr H Masson s’accordent parfaitement avec les travaux de Milankovich qui a calculé l’influence des cycles de la précession-23.000 ans, de l’obliquité – 40.000 ans et de l’excentricité – 100.000 ans de la rotation de la terre autour du soleil. Appliqués au climat au-dessus du 65ième parallèle ces calculs sont confirmés par la comparaison des cycles de variation du rayonnement solaire avec la variation de l’épaisseur des glaces et s’accordent aux cycles de la variations du deutérium.

La précession et l’obliquité du la terre ne changent pas le flux thermique reçu par la terre. La sphère présente toujours une même section au rayonnement solaire mais l’exposition des différentes régions de la terre change avec l’inclinaison de l’axe de rotation de la terre par rapport au plan de l’orbite autour du soleil. Il en résulte l’alternance de périodes glaciaires et interglaciaires. L’excentricité de l’ellipse de rotation de la terre, quasiment un cercle, varier de 0.8 à 0.85 et génère une variation d’énergie solaire de moins de 1 W/m², largement insuffisant pour justifier d’autres changements climatiques.

Le climat ce n’est pas la météo. L’étude de « la » température locale d’une région ne peut être extrapolée sans certaines réserves à la comparaison de la température du climat qui est globale. Un flux thermique est d’autant plus efficace que le gradient de température entre le corps chaud et le corps froid est important. Pour une variation globale de la température de notre planète, celle dont on parle en général, est la globalisation de variations plus grandes aux pôles qu’à l’équateur. L’évolution du climat ne sera pas la même partout ni les conséquences ne seront identiques.

« Un » climatologue n’existe pas. Pour étudier le climat il faut réunir des géologues, des vulcanologues, des biologistes, des minéralogistes, des paléontologues, des chimistes, des physiciens, des mathématiciens, des informaticiens… qui travaillent ensemble. Ce n’est pas un mathématicien ou un autre spécialiste travaillant seul dans son coin qui peut raisonnablement intégrer toutes les connaissances nécessaires pour parler valablement du climat. De plus un bon scientifique confronte ses conclusions à l’avis de ses pairs.

Le GIEC ce sont des représentants de 195 états. Ce sont 350 scientifiques qui travaillent en trois groupes. Leurs rapports sont basés sur une compilation des articles, revues et publications faites dans le monde, le GIEC ne fait pas ses recherches propres. Les projets de rapports sont revus par tous ceux qui en font la demande. Leurs remarques sont prises en compte si pertinentes. Plusieurs milliers de lecteurs ont relu tout ou partie du dernier projet de rapport dont les interventions sont répertoriées. Le rapport fait plusieurs milliers de pages. Qui en a lu toutes les pages, ou même le résumé de 1500 pages si ce n’est « l’executive summary » de quelques dizaines de pages ? Tous les rapports officiels du GIEC ont à ce jour été approuvés en assemblée générale à l’unanimité des membres, un état une voix, USA= Luxembourg. Rien que l’accord unanime d’autant de scientifiques de nombreuses spécialités et d’autant de pays est un gage de convergence scientifique remarquable et lève toute hypothèse de lobbyisme.

Il existe une vingtaine de modèles d’étude du climat dont le GIEC utilise les résultats.

Ces modèles utilisent les méthodes de calculs appliquées il y plus de 50 ans au calcul de résistance des matériaux. Ceux-ci découpent l’élément à calculer en petits éléments y appliquent les équations ad hoc et de proche en proche s’étendent à l’objet entier et par itérations successives, jusqu’à trouver l’équilibre entre tous les petits éléments de la découpe du calcul. Notre planète, sous-sol, mers, océans, terres, atmosphère, troposphère, stratosphère est découpée en blocs sphériques et les équations ou algorithmes de l’interactions de pression, altitude, température, évaporation, effet de serre ,… sont successivement appliqués à chacun de ces éléments et ainsi de suite calculés en boucle de proche en proche jusqu’à ce qu’un équilibre soit trouvé.

Les modèles mesurent les variations du climat par rapport à la moyenne de ces facteurs pour la période 1989-1999. Le mathématicien se souviendra que la variation est la dérivée du signal et elle marque une tendance. On se souviendra aussi, par exemple, que la confirmation du « bozon » déduite d’équations mathématiques écrites plus 25 ans avant, résulte de mesures faites dans l’accélérateur du CERN par la mesure d’un phénome physique qui n’est que la dérivée de l’équation initiale.

Avant d’évaluer le future, les modèles ont été confronté au passé. Ils reproduisent très précisément les mesures des variations de températures enregistrées depuis la fin du XIXième siècle ; ils reconstruisent les variations des températures depuis l’an 1000 avec une variation de +/- 0.2°C ; les températures de cette période ayant été mesurées par l’analyse de « proxy » , des témoins paléontologiques, glaciaires, isotopes,…Ensuite les modèles simulent ce que le climat pourrait être selon divers scénarii d’évolution des émission des gaz à effet de serre de l’an 2000 à l’an 2100.

Le GIEC présente les moyennes des résultats de ces modèles. Ce n’est pas un modèle du GIEC, c’est ce que calculent indépendamment une vingtaine de modèles. Leur convergence est remarquable à moins qu’ils ne se soient tous entendus ou qu’ils se trompent tous de la même manière ?

Selon différents scénarii de variation de la teneur en CO2 de l’atmosphère entre celle de 2000 et celle de 2100, si le CO2 émis diminue nous auront une variation de +0.8°C(+/- 0.2°C), si les émissions restent celles de 2000, ce sera +1.8°C (+/- 0.4°C); si les émissions doublent ce sera +2.8°C (+/- 0.6°C). On se souviendra que selon les mesures de l’observatoire de Mauna Loa en 2000 on mesurait 360 ppm de CO2 dans l’atmosphère et que le 18 avril 2019 on en a mesuré 413.54 ppm (+15%). A ce rythme-là, les prévisions des modèles données ci-dessus risquent d’être obsolètes.

Depuis la fin de l’ère glaciaire il y a environ 10.000 ans jusqu’à la fin du XIXième siècle, la différence de température du climat a été de +5°C, en 10.000 ans tout de même! La France était alors quasiment en totalité recouverte de glace et le niveau des mers était inférieure de 100 à 120 m. Le risque d’augmentation de température de 2 à 5°C d’ici à 2100, 200 ans seulement, ne vaut-il pas la peine de s’y arrêter ?

Que valent ces modèles ? Si les bases scientifiques sur lesquelles ils s’appuient restent à peut près celles que notre planète connaîtra dans le futur alors ne devons-nous pas prendre les conclusions en considération ? D’autre part, si ces bases scientifiques ne sont pas vérifiées dans le futur, alors nous ne savons vraiment pas ce que demain sera, et comme l’autruche, pour nous protéger, nous nous mettons la tête dans le sable.

Réduire la vingtaine de modèles des scientifiques à des nuages de points chaotiques c’est faire peu de cas des analyses multivariables.

Mais aussi, il y a bien longtemps pour que je me souvienne des détails des théories des probabilités que j’ai étudiées et utilisées, mais je me souviens tout de même que les théories des probabilités appliquées à la mécanique quantique reproduisent les lois de la thermodynamique qui elle est bien déterministe. Et pourtant la mécanique quantique vue de loin c’est aussi le chaos.

SCE-info: Nous invitons les lecteurs a consulter notre politique des commentaires, qui met des limites à la longueur des textes :

http://www.science-climat-energie.be/politique-de-commentaires/

En conséquence les longs textes ne pourront plus être publiés.

L’auteur H. Masson étant à l’étranger répondra exceptionnellement à l’article de M. Cauwe dès son retour.

@ Mr Cauwe : j’analyse ici v/texte, spontané mais dense ? Permettez-moi ainsi :

1) être SCEPTIQUE, c-à-d penser hors la masse « consensuelle », relèverait-il à votre avis d’une pathologie ? Que penser alors de TOUS nos bons théoriciens / créateurs / inventeurs / découvreurs qui ont peuplé et -j’espère- peupleront notre sphère, la mettant à l’abri d’une pandémie du type actuel « tout au politiquement correct » ?

2) à propos de vos certitudes relatives au forçage et à ses causes (anthropiques, cela va de soi, hein?), que pensez-vous p.ex. du constat suivant :

= = A net decrease in the Earth’s cloud, aerosol, and surface 340 nm reflectivity during the past 33 yr (1979–2011) = =

https://www.atmos-chem-phys.net/13/8505/2013/

(constaté là par des observations satellites, dont entre autres NASA Goddard incl.?).

Un sujet repris et actualisé en 2017 sur (Ouche, un autre sceptique!) :

= = The last 40 years of global temperature changes can be radiatively explained by a natural reduction in cloud cover. = =

https://notrickszone.com/2019/10/28/scientists-the-entirety-of-the-1979-2017-global-temperature-change-can-be-explained-by-natural-forcing/

Des chiffres autrement plus pointus que ceux de l’excentricité de l’ellipse terre…

3) A destination du grand public, « climat n’est pas météo » dites vous. Nuançons ?

Justement, on en parlait récemment : https://www.climato-realistes.fr/sud-radio-debat-benoit-rittaud-chloe-nabedian-la-meteo-devient-elle-folle/

4) Si l’industrialisation « exponentielle » des 19-20e constitue un fait mesurable et avéré, votre absence de démonstration chiffrée relative aux projections vers 2100 est troublante. Un appui sur GES « CO2 millénariste » prête toujours à caution.

Par ailleurs, pourquoi adoptez-vous là un postulat simplificateur ignorant les échanges océans-atmosphère et bien d’autres variables ? Vous invoquez pourtant la transdisciplinarité, mais vous vous focalisez sur si peu de leurs experts, hors ceux convertis à l’ambiante GIEC (certains d’eux le contestant néanmoins en interne) !

Que signifient vos circonvolutions vers le « boSon » et le quantique, lorsque vous ne citez pas le vent solaire ou celui galactique, voire d’autres facteurs telluriques ?

5) Ah les incantations appuyée sur les modèles « à prédicats » sortis de la bible nourricière du GIEC. Modèles aux résultats (présumés incontestables?) nous donnant une fourchette …à dents divergentes… pour lesquels il suffirait de moyenner pour prouver quoi ? Prendre appui sur le seul horizon historique du climat de +- 30 années pour ensuite projeter son devenir à une échéance de 80 ou 100 suivantes, quelle rigueur scientifique ça inspire t’il à ceux qui raisonnent hors a priori ?

Ces références à 1500 pages « lues » par édition de 5 en 5 ans me fait penser à quelques gourous français fort médiatisés (liste). Pas vous ?

Tandis que vous cautionnez à raison « simulent » et « pourrait » ( = du conditionnel), c-à-d vous admettez l’INCERTITUDE liée à tous les phénomènes non-linéaires qui régissent le climat, (et forcément) à leur structure multivariables ! D’où ces effets de chaos que d’autre auteurs ont souvent invoqué ici avant vous-même. Pourquoi s’appuyer sur un « futur déterminisme », or que tant de gens cultivés le révoquent ? Restant ici attentifs à la transdisciplinarité, lisons (c’est long) ce résumé d’un ouvrage 2015 commis par un philosophe non-climatogue. Instructif ?

= = Hasard, chaos et déterminisme : les limites des prédictions = =

http://www.danielmartin.eu/Philo/Resume.htm

6) Je vous rejoins dans l’affirmation que « nul ne sait ce que demain sera », ni au plan dudit climat, ni d’innombrables comètes à scruter (avec leur parcours d’exactitude imprédictible ?), ni d’une situation de géopolitique (globale) assez peu sécurisante en ce 21e. Enfin la démographie à 10-12 milliards d’êtres en conflits potentiels, ça nous donnera quoi comme T° ambiante, ceci bien avant l’an 2100 ?

Bien cordialement , E.S.

Philippe Cauwe:

1- Je constate que vous commencez votre message par ce que vous croyez être une attaque « ad hominem ». Notre politique est de ne pas s’engager dans ce genre de faiblesse épistémologique et de nous cantonner dans une argumentation « ad rem ». En effet, recourir à ce genre de manœuvre, traduit une faiblesse intellectuelle révelant qu’on a perdu le débat d’idée. Vous semblez en effet ignorer que :

a. Le scepticisme fait partie intégrante de la méthode scientifique (cfr. Poincaré, Popper, Einstein, etc.)

b. Le consensus n’est pas une notion scientifique (cfr. Galilée, Einstein, etc.) mais un outil de gestion sociale d’opinions épidermiques. De plus, le consensus climato-alarmiste que vous évoquez est basé sur des méthodes scientifiquement contestables et contestées pour leur manque d’objectivité et de représentativité.

2- Votre intervention est hors de propos. Mon article est focalisé sur les premières modélisations informatiques du climat, et la découverte fortuite faite par Lorenz du caractère chaotique (au sens mathématique du terme) du système climatique, ainsi que de l’impossibilité qu’il y a, d’une part à calibrer correctement un tel modèle (une conséquence directe de l’hypersensibilité aux conditions initiales et à la valeur des paramètres), et d’autre part à en effectuer des projections à plus ou moins long terme. J’ai ensuite montré par un exemple (« peer reviewed ») qu’aucun progrès en ce qui concerne la fiabilité des modèles climatiques n’a été effectué depuis 50 ans, malgré l’utilisation de super-ordinateurs : cela tient à la structure des équations et à la nature des algorithmes utilisés. Il convient donc de changer de paradigme. Contrairement à vous, Je ne me suis livré, à aucun moment, à des commentaires critiques ou dithyrambiques sur des données expérimentales plus ou moins sélectionnées (« cherry picking »). C’est en cela que votre intervention est hors de propos.

3- Vous me qualifiez « d’obscur mathématicien ». Apprenez à ne jamais sous-estimer quelqu’un que vous ne connaissez pas. Il est possible qu’il soit renommé dans des cercles que vous ne fréquentez pas, qu’il soit actif sur des réseaux sociaux que vous ignorez, qu’il publie dans des revues que vous ne lisez pas, qu’il habite l’étranger, et fuit ou néglige les médias mainstream du pays où vous habitez. Je ne me sens nullement obligé de vous détailler mon CV ici, mais sachez que je ne suis pas mathématicien mais docteur-ingénieur, que j’ai, par expérience professionnelle et académique, acquis un ensemble de connaissances qui me permettent d’avoir une vision holistique de systèmes aussi complexes que le système climatique et sa modélisation (chose que les fonctionnaires et spécialistes auto-proclamés du GIEC n’ont pas) ; je dispose en plus d’une expérience d’audit et de monitoring de projets internationaux, dont les budgets sont comparables à ceux du GIEC. Je pense donc être autorisé, en toute indépendance, de formuler un avis circonstancié sur les travaux du GIEC, qui n’ont jamais été audités par des experts indépendants, chose que le GIEC refuse obstinément.

4- Ce dernier fait suffit à discréditer les travaux du GIEC, car on ne peut à la fois être juge et partie, et on peut légitimement penser que les « spécialistes auto-proclamés du Giec » pensent surtout à récolter des subsides pour poursuivre leurs travaux hyperspécialisés, en utilisant des outils mal adaptés (je dirais de façon imagée « qu’ils essayent de châtrer des mouches avec des gants de boxe »). Je crains bien qu’ils finiront par connaître tout sur rien, sans pour cela faire avancer la compréhension du système climatique d’un iota. On ne base pas une politique énergétique sur des bases aussi peu solides, à moins de tomber dans l’hystérie collective, orchestrée par de savantes manœuvres de manipulation de masse. Mais ceci est un autre débat également.

5- Je ne répondrai pas au flot de considérations hors de propos que vous alignez dans votre message. Emmanuel Simon s’en est déjà chargé. Pour ma part, je me contenterai d’évoquer le Principe de Brandolini (The bullshit asymmetry: « the amount of energy needed to refute bullshit is an order of magnitude bigger than to produce it «) pour justifier mon absence de réaction complémentaire aux propos d’un troll . Car, je suis au regret de vous dire, que c’est à cela que vous vous apparentez lorsque vous postez des messages du style de celui auquel je viens de répondre.

Christian Ost :

Paradigme complémentaire à l’état chaotique.

L’origine de ce paradigme complémentaire à l’état chaotique résulte d’observations et de mesures préliminaires réalisées sur des micros vortex cycloniques générés par brise de mer.

Les déclenchements de ces petits vortex ne disposent pas d’une énergie thermique suffisante pour générer un déplacement d’air à la vitesse de 0.1 Mach (30 m/s) en +/- 0.5 seconde dans leur tuba [Holton et autres]. Pour Météo France, ce transfert d’énergie thermique en énergie cinétique résulterait d’une propriété physique située à la base de ces vortex qu’il dénomme couvercle. Cette propriété couvercle reste à déterminer.

Les transferts d’énergie thermique en énergie cinétique générés dans les vortex sont localisés dans un volume cylindrique par une paroi gazeuse. Dans les moteurs thermiques, les transferts d’énergie thermique en énergie cinétique sont obtenus grâce à une enceinte constituée de parois solides. Une meilleure connaissance des propriétés des parois gazeuses qui délimitent les vortex pourrait procurer des informations complémentaires sur l’incidence de l’effet papillon dans l’atmosphère et l’état chaotique.

La localisation et la prévision d’enclenchements des micros vortex générés par brise de mer sont totalement aléatoires. Cette impossibilité de prévisions est justifiée par l’état chaotique de la thermodynamique de l’atmosphère. Les études réalisées sur les diables de poussière [J. Ito, H. Niino, Mikio Nakanishi et autres] confirment l’état chaotique des enclenchements et l’évolution des déplacements verticaux des vortex. Le suivi de ces recherches est sollicité par plusieurs scientifiques [Ohno, Takemi, J. Ito, Niino Nakanishi et autres].

Les masses d’air anticycloniques et cycloniques qui composent l’atmosphère sont également constituées de déplacements verticaux délimités par des parois gazeuses. L’évolution dans le temps de la thermodynamique de ces masses d’air chaotiques sont imprévisibles. Les prévisions météos à long terme ne sont pas actuellement réalisables.

Une étude complémentaire sur la justification de ces turbulences cycloniques et anticycloniques pourrait justifier l’existence d’un paradigme complémentaire à l’état chaotique de l’atmosphère.

Ce paradigme pourrait permettre de prévoir la météo sur une période de 6 mois, d’évaluer la faisabilité d’une géo ingénierie de l’atmosphère et autres.

Une simulation numérique permettrait d’évaluer la cohérence de cette démarche.

La collaboration de partenaires intéressés par cette recherche est sollicitée.

Accepteriez-vous, Monsieur Masson et/ou autres, de convenir d’un échange d’informations relatives à ce paradigme complémentaire à l’état chaotique ?

Merci pour ces précisions et critiques très intéressantes. Juste une question de béotien ou d’ignare: connait-on le niveau des émissions NATURELLES de CO2 dans l’atmosphère depuis la Révolution Industrielle ? Je pose cette question car j’ai relevé les chiffres donnés par le GIEC pour les émissions anthropiques depuis cette R.I., et les chiffres des émissions NATURELLES au moment même de la R I. mais rien sur ces émissions NATURELLES depuis la R.I. Elles ne se sont pas subitement arrêtées quand même.. !

Les chiffres utilisés par le GIEC se déduisent de la figure extraite du rapport d’avancement AR6 du GIEC à partir des figures updatées de l’IPCC AR4 ch7 : « C in atmosphere 829 ± 10 (GTC), Accumulation 4 GTC/yr, Total Incoming Flux 78.4+1+7.8+116=0.1 = 205 GTC/yr of which Anthropogenic Flux 7.8+1.7 =9.5 GTC/yr. Average Residence Time around 4 years (829/(205-4) and Time to Double C content in atmosphere 829/4 = 207 yr.

Les émissions totales annuelles sont de l’ordre de 220 GT de carbone/an (ou 806 GT de CO2/an), les émissions anthropiques étant égales à ~10 GT de carbone/an (ou 37 GT de CO2/an), soit environ 5% des émissions totales

Il convient de souligner que ces flux sont des approximations grossières, personne n’étant capable de mesurer les émissions naturelles avec une précision acceptable et les émissions anthropiques étant définies indirectement par des « règles » édictées par le GIEC, qui valent ce qu’elles valent, et qui sont estimées sur base des activités économiques et industrielles des divers pays, ainsi que de leur population et de leur niveau de vie (mesuré par le PIB).

On peut donc craindre que les augmentations annuelles des émissions reportées, ainsi que la différence entre flux entrant et sortant de l’atmosphère tombent dans les marges d’erreur de ces estimations.

Il convient également de noter que le Principe d’Indiscernabilité en chimie fait que, quels que soient les abondances isotopiques dans un mélange gazeux, le comportement macroscopique physico-chimique reste le même, c’est le principe même de l’utilisation répandue des traceurs radioactifs en sciences et techniques. Il est donc conceptuellement incorrect d’essayer de déterminer, sur base de proportions isotopiques, séparément un flux de CO2 anthropique d’un flux naturel, et également d’essayer de déterminer quelle fraction du flux anthropique s’accumule dans l’atmosphère.

Mais soit. Sur base de ces chiffres, on peut déduire que

• Le temps de séjour moyen dans l’atmosphère d’une molécule de CO2 est de l’ordre de 4 ans (quantité de carbone dans l’atmosphère divisé par le flux sortant, par définition = 829/201). La distribution des temps de séjour suit approximativement une loi exponentielle, avec une queue de cette distribution cependant plus « épaisse » que celle d ‘une exponentielle, par suite d’échanges de flux gazeux (absorption-désorption) avec des réservoirs naturels (océans, biosphère, etc.) ;

• Il faudra 207 années pour doubler la concentration en CO2 dans l’atmosphère [829/(205-201)]. Ce doublement de concentration atmosphérique correspond via le concept de sensibilité climatique (une invention du GIEC) à une augmentation de la température moyenne globale (une autre invention du GIEC) de l’ordre de 1 à 5°C, si l’on en croit les modèles du GIEC. Il convient de noter que les résultats les plus récents se rapprochent de cette limite inférieure de 1°C, et tombent même en-dessous. Gardons le chiffre de 1°C pour faire simple, et raisonnons en termes d’ordre de grandeur.

Or un pays comme la France est responsable (selon l’AIE) d’un pourcent des émissions anthropiques (la Belgique 0.3 %), ou un pour mille des émissions globales.

Une politique zéro carbone imposée à la France, avec effet immédiat, et s’étendant sur deux siècles, réduirait donc l’augmentation de température globale moyenne de l’ordre du millième de degrés. Vous avez dit se chatouiller pour se faire rire ? ou plutôt se faire pleurer, quand on voit le coût faramineux (environ 150 milliards pour la France, selon la Cour des Comptes) nécessaire pour mener à bien une telle transition énergétique. Gabegie, incompétence ou corruption ?

Bonjour, de toutes évidence, l’escroquerie Carbo-climatique en bande organisée est un outil à l’usage des mondialistes Onusiens conduit par le patibulaire Davosien Klaus Schwab. De tous temps les climats ont changé et par définition le climat est chaotique: https://static.climato-realistes.fr/2021/01/FicheACR6-1.pdf . Tout le monde se fiche que le taux de C02 dans l’air soit de 0,03 ou de 0,04 %, sauf les néo-religieux et les voyous en col blanc qui profitent de cette supercherie. Merci. Cordialement

Merci à Henri Masson pour sa réponse du mois d’avril 2023.

Je crois comprendre que les émissions naturelles de CO2 ne se sont DONC pas arrêtées (subitement, mystérieusement) à cause de la Révolution Industrielle…

Je fais cette remarque parce que je trouve le raisonnement de Jean Jouzel (dans son livre « 2°C ») assez idéologique: grosso modo, si les Humains arrêtent d’émettre du CO2 dans l’air, alors la terre (gentille terre…) reviendra à sa température du 18ème siècle !

Ce monsieur estime donc (je le lis comme ça) que la terre, elle même, toute seule, serait incapable d’émettre du CO2…( je crois savoir, quand même, que les émissions de CO2 sur terre ont déjà été énormes avant même que les Hominidés y produisent quoi que ce soit de polluant..).

Autre supposition de Jean Jouzel: la terre ne peut se réchauffer que par l’effet de serre….

Sans oublier le « Must » en matière idéologique de la part de ce (toujours ?) scientifique: « le capitalisme est incapable de lutter contre le réchauffement climatique » !

Jean Jouzel pense donc que l’anticapitalisme (ou l’a-capitalisme ) le permettrait !

Ce qui laisse supposer que, lui comme d’autres prétendus « écologistes », ont abandonné la déontologie originelle de l’humilité écologiste (face à la nature) pour croire, avec une arrogance prométhéenne peu écologique, que la terre possèderait un thermostat.

Comme toujours, les militants fanatiques de causes « nobles » finissent pas faire exactement le contraire de ce qu’ils affichent sur eux.